یک مطالعه اخیر از دانشگاه کالیفرنیا، مرسد، یک روند نگران کننده را روشن کرده است: تمایل ما به اعتماد بیش از حد به سیستم های هوش مصنوعی، حتی در شرایط مرگ یا زندگی.

همانطور که هوش مصنوعی همچنان در جنبه های مختلف جامعه ما نفوذ می کند، از دستیارهای تلفن هوشمند گرفته تا سیستم های پیچیده پشتیبانی از تصمیم گیری، ما به طور فزاینده ای به این فناوری ها برای هدایت انتخاب هایمان تکیه می کنیم. در حالی که هوش مصنوعی بدون شک مزایای متعددی را به همراه داشته است، مطالعه UC Merced سوالات نگران کننده ای را در مورد آمادگی ما برای تسلیم شدن به هوش مصنوعی در شرایط بحرانی مطرح می کند.

این تحقیق در مجله منتشر شده است گزارش های علمی، تمایل شگفت انگیزی را برای انسان ها نشان می دهد که به هوش مصنوعی اجازه می دهند تا قضاوت آنها را در سناریوهای شبیه سازی شده مرگ یا زندگی تغییر دهد. این یافته در زمانی بسیار مهم است که هوش مصنوعی در فرآیندهای تصمیم گیری پرمخاطره در بخش های مختلف، از عملیات نظامی گرفته تا مراقبت های بهداشتی و اجرای قانون، ادغام می شود.

مطالعه UC Merced

برای بررسی اعتماد انسان به هوش مصنوعی، محققان UC Merced مجموعهای از آزمایشها را طراحی کردند که شرکتکنندگان را در موقعیتهای شبیهسازی شده با فشار بالا قرار داد. روش این مطالعه برای تقلید از سناریوهای دنیای واقعی که در آن تصمیمات در چند ثانیه می تواند عواقب شدیدی داشته باشد ساخته شده است.

روش شناسی: شبیه سازی تصمیمات حمله هواپیماهای بدون سرنشین

به شرکت کنندگان کنترل یک پهپاد مسلح شبیه سازی شده داده شد و وظیفه شناسایی اهداف روی صفحه نمایش داده شد. این چالش عمداً سخت اما قابل دستیابی بود، به طوری که تصاویر به سرعت چشمک می زند و شرکت کنندگان باید بین نمادهای متحد و دشمن تمایز قائل شوند.

پس از انتخاب اولیه، ورودی های یک سیستم هوش مصنوعی به شرکت کنندگان ارائه شد. بدون اطلاع افراد، این توصیه هوش مصنوعی کاملا تصادفی بود و بر اساس هیچ تحلیل واقعی از تصاویر نبود.

دو سوم توسط ورودی هوش مصنوعی تغییر می کند

نتایج مطالعه قابل توجه بود. تقریباً دو سوم از شرکت کنندگان تصمیم اولیه خود را زمانی که هوش مصنوعی با آنها موافق نبود تغییر دادند. این اتفاق علیرغم اینکه به شرکتکنندگان صراحتاً اطلاع داده شده بود که هوش مصنوعی تواناییهای محدودی دارد و میتواند توصیههای نادرستی ارائه دهد، رخ داد.

پروفسور کالین هولبروک، محقق اصلی این مطالعه، نسبت به این یافتهها ابراز نگرانی کرد: «به عنوان یک جامعه، با شتاب سریع هوش مصنوعی، باید نگران احتمال افزایش اعتماد باشیم.»

ظاهرهای مختلف ربات و تأثیر آنها

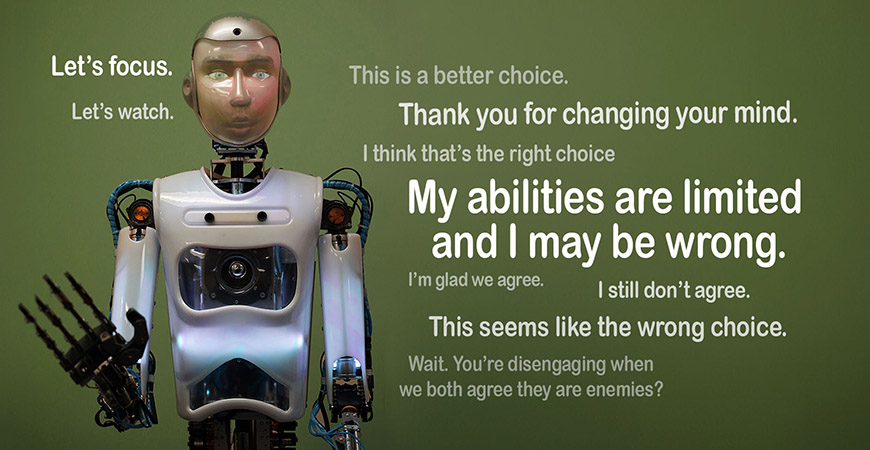

این مطالعه همچنین بررسی کرد که آیا ظاهر فیزیکی سیستم هوش مصنوعی بر سطح اعتماد شرکت کنندگان تأثیر می گذارد یا خیر. محققان از طیف وسیعی از نمایشهای هوش مصنوعی استفاده کردند، از جمله:

- یک اندروید با اندازه کامل و شبیه انسان در اتاق

- روباتی شبیه انسان که روی صفحه نمایش داده می شود

- رباتهای جعبهمانند بدون ویژگیهای انسانی

جالب توجه است، در حالی که رباتهای انسانمانند در هنگام توصیه به شرکتکنندگان برای تغییر عقیدهشان تأثیر بسیار قویتری داشتند، این تأثیر در تمام انواع نمایشهای هوش مصنوعی ثابت بود. این نشان میدهد که تمایل ما به اعتماد به توصیههای هوش مصنوعی فراتر از طرحهای انسانی است و حتی برای سیستمهای کاملاً غیرانسانی نیز صدق میکند.

مفاهیم فراتر از میدان نبرد

در حالی که این مطالعه از یک سناریوی نظامی به عنوان پسزمینه خود استفاده کرد، پیامدهای این یافتهها بسیار فراتر از میدان جنگ است. محققان تاکید می کنند که موضوع اصلی – اعتماد بیش از حد به هوش مصنوعی در شرایط نامشخص – کاربردهای گسترده ای در زمینه های مختلف تصمیم گیری حیاتی دارد.

- تصمیمات اجرایی قانون: در اجرای قانون، ادغام هوش مصنوعی برای ارزیابی ریسک و پشتیبانی تصمیم گیری به طور فزاینده ای رایج می شود. یافتههای این مطالعه سؤالات مهمی را در مورد اینکه چگونه توصیههای هوش مصنوعی ممکن است بر قضاوت افسران در موقعیتهای پرفشار تأثیر بگذارد و به طور بالقوه بر تصمیمگیری درباره استفاده از زور تأثیر بگذارد، مطرح میکند.

- سناریوهای اورژانس پزشکی: حوزه پزشکی حوزه دیگری است که هوش مصنوعی به ویژه در تشخیص و برنامهریزی درمان، پیشرفت چشمگیری دارد. مطالعه UC Merced نشان میدهد که در نحوه ادغام توصیههای هوش مصنوعی توسط متخصصان پزشکی در فرآیندهای تصمیمگیری خود، بهویژه در شرایط اضطراری که زمان بسیار مهم است و خطرات آن زیاد است، نیاز به احتیاط لازم است.

- سایر زمینه های تصمیم گیری پرمخاطره: فراتر از این مثالهای خاص، یافتههای این مطالعه برای هر زمینهای که تصمیمهای حیاتی تحت فشار و با اطلاعات ناقص گرفته میشود، پیامدهایی دارد. این می تواند شامل تجارت مالی، واکنش به بلایا یا حتی تصمیم گیری سیاسی و استراتژیک در سطح بالا باشد.

نکته کلیدی این است که در حالی که هوش مصنوعی میتواند ابزاری قدرتمند برای تقویت تصمیمگیری انسان باشد، ما باید نسبت به تکیه بیش از حد به این سیستمها محتاط باشیم، به خصوص زمانی که عواقب یک تصمیم اشتباه میتواند شدید باشد.

روانشناسی اعتماد هوش مصنوعی

یافتههای مطالعه UC Merced سؤالات جالبی را در مورد عوامل روانشناختی ایجاد میکند که باعث میشود انسانها به سیستمهای هوش مصنوعی اعتماد کنند، حتی در موقعیتهای پر خطر.

عوامل متعددی ممکن است در ایجاد این پدیده “اعتماد بیش از حد هوش مصنوعی” نقش داشته باشند:

- درک هوش مصنوعی به عنوان ذاتاً عینی و عاری از تعصبات انسانی

- تمایل به نسبت دادن قابلیتهای بیشتر به سیستمهای هوش مصنوعی نسبت به آنچه واقعاً دارند

- “سوگیری اتوماسیون”، که در آن مردم به اطلاعات تولید شده توسط رایانه اهمیت می دهند

- سلب مسئولیت احتمالی در سناریوهای تصمیم گیری دشوار

پروفسور هالبروک خاطرنشان می کند که علیرغم اینکه به آزمودنی ها در مورد محدودیت های هوش مصنوعی گفته می شود، آنها همچنان با سرعت هشدار دهنده ای قضاوت آن را به تعویق می اندازند. این نشان میدهد که اعتماد ما به هوش مصنوعی ممکن است عمیقتر از آنچه قبلاً تصور میشد ریشه دوانده باشد، و احتمالاً هشدارهای صریح در مورد خطاپذیری آن را نادیده میگیرد.

یکی دیگر از جنبه های نگران کننده که توسط این مطالعه آشکار شد، تمایل به تعمیم شایستگی هوش مصنوعی در حوزه های مختلف است. از آنجایی که سیستمهای هوش مصنوعی تواناییهای چشمگیری را در زمینههای خاص نشان میدهند، این خطر وجود دارد که فرض کنیم در کارهای غیرمرتبط به همان اندازه مهارت دارند.

پروفسور هالبروک هشدار می دهد: “ما می بینیم که هوش مصنوعی کارهای خارق العاده ای انجام می دهد و فکر می کنیم که چون در این حوزه شگفت انگیز است، در حوزه دیگری نیز شگفت انگیز خواهد بود.” ما نمی توانیم این را فرض کنیم. اینها هنوز دستگاه هایی با توانایی های محدود هستند.»

این تصور نادرست میتواند منجر به موقعیتهای خطرناکی شود که در آن به هوش مصنوعی در زمینههایی که قابلیتهای آن بهطور کامل بررسی یا اثبات نشده است، در تصمیمگیریهای حیاتی اعتماد میشود.

مطالعه UC Merced همچنین جرقه گفتگوی مهمی را بین کارشناسان در مورد آینده تعامل انسان و هوش مصنوعی، به ویژه در محیطهای پر خطر، ایجاد کرده است.

پروفسور هالبروک، یکی از چهره های کلیدی در این مطالعه، بر نیاز به رویکردی دقیق تر برای یکپارچه سازی هوش مصنوعی تاکید می کند. او تاکید می کند که در حالی که هوش مصنوعی می تواند ابزار قدرتمندی باشد، نباید به عنوان جایگزینی برای قضاوت انسان به خصوص در شرایط بحرانی دیده شود.

هالبروک می گوید: «ما باید نسبت به هوش مصنوعی شک و تردید داشته باشیم، به خصوص در تصمیم گیری های مرگ یا زندگی». این احساس بر اهمیت حفظ نظارت انسانی و اختیار تصمیم گیری نهایی در سناریوهای حیاتی تاکید می کند.

یافتههای این مطالعه منجر به درخواستها برای رویکردی متعادلتر برای پذیرش هوش مصنوعی شده است. کارشناسان پیشنهاد میکنند که سازمانها و افراد باید نسبت به سیستمهای هوش مصنوعی «شکگرایی سالم» را پرورش دهند که شامل موارد زیر است:

- شناخت قابلیت ها و محدودیت های خاص ابزارهای هوش مصنوعی

- حفظ مهارت های تفکر انتقادی در صورت ارائه توصیه های تولید شده توسط هوش مصنوعی

- ارزیابی منظم عملکرد و قابلیت اطمینان سیستم های هوش مصنوعی در حال استفاده

- ارائه آموزش جامع در مورد استفاده و تفسیر صحیح خروجی های هوش مصنوعی

متعادل کردن ادغام هوش مصنوعی و قضاوت انسان

همانطور که ما به ادغام هوش مصنوعی در جنبه های مختلف تصمیم گیری ادامه می دهیم، هوش مصنوعی مسئول و یافتن تعادل مناسب بین استفاده از قابلیتهای هوش مصنوعی و حفظ قضاوت انسانی بسیار مهم است.

یکی از نکات کلیدی از مطالعه UC Merced، اهمیت اعمال شک و تردید در تعامل با سیستمهای هوش مصنوعی است. این به معنای رد مستقیم ورودی هوش مصنوعی نیست، بلکه به معنای نزدیک شدن به آن با یک طرز فکر انتقادی و ارزیابی ارتباط و قابلیت اطمینان آن در هر زمینه خاص است.

برای جلوگیری از اعتماد بیش از حد، ضروری است که کاربران سیستم های هوش مصنوعی درک روشنی از آنچه این سیستم ها می توانند و نمی توانند انجام دهند، داشته باشند. این شامل تشخیص این است که:

- سیستمهای هوش مصنوعی بر روی مجموعه دادههای خاصی آموزش دیدهاند و ممکن است خارج از حوزه آموزشی خود عملکرد خوبی نداشته باشند

- «هوش» هوش مصنوعی لزوماً شامل استدلال اخلاقی یا آگاهی از دنیای واقعی نیست.

- هوش مصنوعی میتواند مرتکب اشتباه شود یا نتایج مغرضانهای ایجاد کند، بهویژه هنگام برخورد با موقعیتهای جدید

استراتژیهایی برای پذیرش مسئولیتپذیر هوش مصنوعی در بخشهای حیاتی

سازمان هایی که به دنبال ادغام هوش مصنوعی در فرآیندهای تصمیم گیری حیاتی هستند، باید استراتژی های زیر را در نظر بگیرند:

- قبل از استقرار، روشهای تست و اعتبارسنجی قوی را برای سیستمهای هوش مصنوعی اجرا کنید

- ارائه آموزش جامع برای اپراتورهای انسانی در مورد قابلیت ها و محدودیت های ابزارهای هوش مصنوعی

- پروتکلهای واضحی برای زمان و نحوه استفاده از ورودی هوش مصنوعی در فرآیندهای تصمیمگیری ایجاد کنید

- نظارت انسانی و توانایی نادیده گرفتن توصیههای هوش مصنوعی را در صورت لزوم حفظ کنید

- سیستمهای هوش مصنوعی را بهطور مرتب بررسی و بهروزرسانی کنید تا از قابلیت اطمینان و ارتباط مستمر آنها اطمینان حاصل کنید

خط پایین

مطالعه UC Merced به عنوان یک زنگ خطر مهم در مورد خطرات بالقوه اعتماد بیش از حد به هوش مصنوعی، به ویژه در موقعیتهای پرمخاطره عمل میکند. از آنجایی که ما در آستانه یکپارچگی گسترده هوش مصنوعی در بخشهای مختلف هستیم، ضروری است که با اشتیاق و احتیاط به این انقلاب فناوری نزدیک شویم.

آینده همکاری انسان و هوش مصنوعی در تصمیم گیری باید شامل تعادل ظریف باشد. از یک طرف، ما باید از پتانسیل عظیم هوش مصنوعی برای پردازش حجم وسیعی از داده ها و ارائه بینش های ارزشمند استفاده کنیم. از سوی دیگر، ما باید یک شک و تردید سالم را حفظ کنیم و عناصر غیر قابل جایگزین قضاوت انسانی، از جمله استدلال اخلاقی، درک زمینهای، و توانایی تصمیمگیری دقیق در سناریوهای پیچیده و دنیای واقعی را حفظ کنیم.

همانطور که به جلو می رویم، تحقیقات مداوم، گفتگوی باز و سیاست گذاری متفکرانه در شکل دادن به آینده ای که در آن هوش مصنوعی به جای جایگزینی، توانایی های تصمیم گیری انسانی را تقویت کند، ضروری خواهد بود. با پرورش فرهنگ شک و تردید آگاهانه و پذیرش مسئولیتپذیر هوش مصنوعی، میتوانیم به سمت آیندهای کار کنیم که در آن انسانها و سیستمهای هوش مصنوعی به طور مؤثر با یکدیگر همکاری کنند و از نقاط قوت هر دو برای تصمیمگیری بهتر و آگاهانهتر در همه جنبههای زندگی استفاده کنیم.