راه حل های محور AI هر روز به سرعت در صنایع ، خدمات و محصولات متنوع اتخاذ می شوند. با این حال ، اثربخشی آنها کاملاً به کیفیت داده هایی که در آن آموزش داده می شود بستگی دارد – جنبه ای که اغلب در فرآیند ایجاد مجموعه داده ها سوء تفاهم یا نادیده گرفته می شود.

از آنجا که مقامات حفاظت از داده ها بررسی چگونگی تراز کردن فن آوری های هوش مصنوعی با مقررات حریم خصوصی و محافظت از داده ها را افزایش می دهند ، شرکت ها به روش های سازگار و اخلاقی با فشار فزاینده ای برای منبع ، حاشیه نویسی و پالایش داده ها روبرو می شوند.

آیا واقعاً یک رویکرد اخلاقی برای ساختن مجموعه داده های هوش مصنوعی وجود دارد؟ بزرگترین چالش های اخلاقی شرکت ها چیست و چگونه آنها را به آنها پرداخته است؟ و چگونه می توان چارچوب های قانونی در حال تحول بر در دسترس بودن و استفاده از داده های آموزشی تأثیر گذاشت؟ بیایید این سؤالات را بررسی کنیم.

حریم خصوصی داده ها و هوش مصنوعی

با توجه به ماهیت خود ، هوش مصنوعی به بسیاری نیاز دارد داده های شخصی برای اجرای کارها این نگرانی در مورد جمع آوری ، صرفه جویی و استفاده از این اطلاعات ایجاد کرده است. بسیاری از قوانین در سراسر جهان استفاده از داده های شخصی را تنظیم و محدود می کنند ، از GDPR و قانون AI که اخیراً معرفی شده در اروپا گرفته تا HIPAA در ایالات متحده است ، که دسترسی به داده های بیمار در صنعت پزشکی را تنظیم می کند.

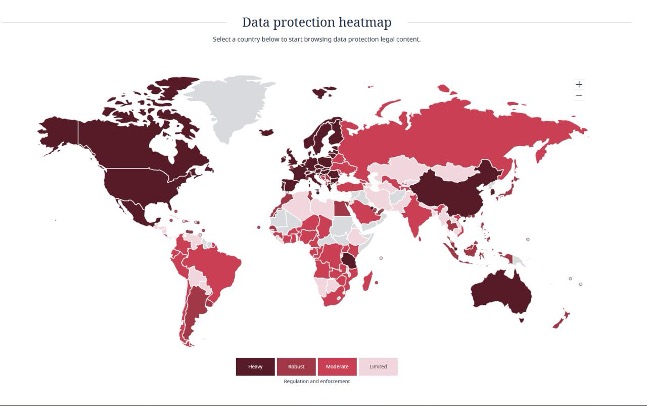

مرجع چگونگی قوانین سختگیرانه حمایت از داده ها در سراسر جهان / DLA Piper

به عنوان مثال ، چهارده ایالت ایالات متحده در حال حاضر قوانین جامع حفظ حریم خصوصی داده ها را در اختیار دارد و شش مورد دیگر در سال 2025 و اوایل سال 2026 نیز به مرحله اجرا در می آیند. دولت جدید تغییر رویکرد خود را به اجرای حریم خصوصی داده ها در سطح فدرال نشان داده است. تمرکز اصلی مقررات هوش مصنوعی است ، و بر تقویت نوآوری به جای تحمیل محدودیت ها تأکید می کند. این تغییر شامل می شود تکرار دستورات اجرایی قبلی در مورد هوش مصنوعی و معرفی دستورالعمل های جدید برای هدایت توسعه و کاربرد آن.

قانون حمایت از داده ها در کشورهای مختلف در حال تحول است: در اروپا ، قوانین سختگیرانه تر هستند ، در حالی که در آسیا یا آفریقا ، آنها تمایل به سخت گیری کمتری دارند.

با این حال ، اطلاعات شناسایی شخصی (PII) – مانند تصاویر صورت ، اسناد رسمی مانند گذرنامه یا هر داده شخصی حساس دیگر – به طور کلی در اکثر کشورها تا حدی محدود می شود. براساس تجارت و توسعه سازمان ملل متحد ، جمع آوری ، استفاده و به اشتراک گذاری اطلاعات شخصی به اشخاص ثالث بدون اطلاع و رضایت مصرف کنندگان ، نگرانی عمده ای برای اکثر جهان است. 137 از 194 کشور جهان مقررات مربوط به حفاظت از داده ها و حریم خصوصی را داشته باشید. در نتیجه ، بیشتر شرکت های جهانی اقدامات احتیاطی گسترده ای را برای جلوگیری از استفاده از PII برای آموزش مدل انجام می دهند ، زیرا مقررات مانند اتحادیه اروپا به طور جدی چنین شیوه هایی را ممنوع می کند ، با استثنائات نادر در سوله های به شدت تنظیم شده مانند اجرای قانون.

با گذشت زمان ، قوانین حفاظت از داده ها جامع تر و در سطح جهانی اجرا می شوند. شرکت ها شیوه های خود را برای جلوگیری از چالش های قانونی و برآورده کردن الزامات حقوقی و اخلاقی در حال ظهور تطبیق می دهند.

شرکت ها برای دریافت داده از چه روش هایی استفاده می کنند؟

بنابراین ، هنگام مطالعه مسائل مربوط به حفاظت از داده ها برای مدل های آموزشی ، ابتدا درک این موارد ضروری است که شرکت ها این داده ها را به دست می آورند. سه منبع اصلی و اصلی داده وجود دارد.

این روش جمع آوری داده ها از سیستم عامل های شلوغی ، سهام رسانه ها و مجموعه داده های منبع باز امکان پذیر است.

توجه به این نکته حائز اهمیت است که رسانه های سهام عمومی مشمول توافق نامه های مختلف صدور مجوز هستند. حتی یک مجوز با استفاده از تجاری اغلب به صراحت بیان می کند که از محتوا برای آموزش مدل استفاده نمی شود. این انتظارات از نظر پلتفرم متفاوت است و مشاغل را ملزم به تأیید توانایی خود در استفاده از محتوا به روش های مورد نیاز خود می کند.

حتی وقتی شرکت های هوش مصنوعی محتوا را به صورت قانونی بدست می آورند ، هنوز هم می توانند با برخی از مسائل روبرو شوند. پیشرفت سریع آموزش مدل AI از چارچوب های حقوقی بسیار فراتر رفته است ، به این معنی که قوانین و مقررات مربوط به داده های آموزش AI هنوز در حال تحول است. در نتیجه ، شرکت ها باید در مورد تحولات حقوقی آگاه باشند و قبل از استفاده از محتوای سهام برای آموزش AI ، توافق نامه های صدور مجوز را با دقت بررسی کنند.

یکی از ایمن ترین روش های تهیه مجموعه داده شامل ایجاد محتوای منحصر به فرد ، مانند فیلمبرداری افراد در محیط های کنترل شده مانند استودیوها یا مکان های فضای باز است. قبل از شرکت ، افراد برای استفاده از PII خود فرم رضایت نامه امضا می کنند ، و مشخص می کنند چه داده هایی جمع آوری می شود ، چگونه و از کجا استفاده می شود و چه کسی به آن دسترسی خواهد داشت. این امر حمایت کامل قانونی را تضمین می کند و به شرکتها اطمینان می دهد که آنها با ادعای استفاده از داده های غیرقانونی روبرو نخواهند شد.

اشکال اصلی این روش هزینه آن است ، به ویژه هنگامی که داده ها برای موارد لبه یا پروژه های در مقیاس بزرگ ایجاد می شود. با این حال ، شرکت ها و شرکت های بزرگ به طور فزاینده ای حداقل به دو دلیل از این رویکرد استفاده می کنند. اول ، این امر رعایت کامل با کلیه استانداردها و مقررات قانونی را تضمین می کند. دوم ، این داده ها را در اختیار شرکت ها قرار می دهد که کاملاً متناسب با سناریوها و نیازهای خاص خود باشد و بیشترین دقت را در آموزش مدل تضمین می کند.

- تولید داده مصنوعی

استفاده از ابزارهای نرم افزاری برای ایجاد تصاویر ، متن یا فیلم ها بر اساس سناریوی معین. با این حال ، داده های مصنوعی محدودیت هایی دارند: بر اساس پارامترهای از پیش تعریف شده تولید می شود و فاقد تنوع طبیعی داده های واقعی است.

این فقدان می تواند بر مدل های هوش مصنوعی تأثیر منفی بگذارد. در حالی که برای همه موارد مهم نیست و همیشه اتفاق نمی افتد ، اما یادآوری آن هنوز هم مهم است “سقوط مدل“-نکته ای که اعتماد بیش از حد به داده های مصنوعی باعث تخریب مدل می شود و منجر به خروجی های با کیفیت ضعیف می شود.

داده های مصنوعی هنوز هم می توانند برای کارهای اساسی ، مانند شناخت الگوهای کلی ، شناسایی اشیاء یا تمایز عناصر بصری اساسی مانند چهره ، بسیار مؤثر باشند.

با این حال ، بهترین گزینه نیست که یک شرکت نیاز به آموزش یک مدل به طور کامل از ابتدا یا برخورد با سناریوهای نادر یا بسیار خاص داشته باشد.

آشکارترین شرایط در محیط های داخل کابین ، مانند راننده ای که توسط کودک حواس پرتی است ، شخصی که در پشت چرخ خستگی می کند یا حتی مواردی از رانندگی بی پروا است ، رخ می دهد. این نقاط داده معمولاً در مجموعه داده های عمومی موجود نیست – و نه باید باشند – زیرا افراد واقعی را در تنظیمات خصوصی درگیر می کنند. از آنجا که مدل های هوش مصنوعی برای تولید خروجی های مصنوعی به داده های آموزش متکی هستند ، آنها برای نشان دادن سناریوهایی که هرگز به طور دقیق با آنها روبرو نشده اند ، تلاش می کنند.

هنگامی که داده های مصنوعی با شکست مواجه می شوند ، داده های ایجاد شده – که از طریق محیط های کنترل شده با بازیگران واقعی جمع آوری می شوند – به راه حل تبدیل می شوند.

ارائه دهندگان راه حل داده ها کیماکر دوربین ها را در اتومبیل قرار دهید ، بازیگران را استخدام کنید و اقداماتی از قبیل مراقبت از کودک ، نوشیدن از بطری یا نشان دادن علائم خستگی را ضبط کنید. بازیگران قراردادهایی را صریحاً موافقت می کنند که از داده های خود برای آموزش AI استفاده کنند و از رعایت قوانین حریم خصوصی اطمینان حاصل کنند.

مسئولیت ها در فرآیند ایجاد مجموعه داده

هر یک از شرکت کنندگان در این فرآیند ، از مشتری تا شرکت حاشیه نویسی ، مسئولیت های خاصی را در توافق خود بیان می کند. اولین قدم ، ایجاد قرارداد است که به معنای ماهیت رابطه ، از جمله بندهای عدم افشای و مالکیت معنوی است.

بیایید اولین گزینه برای کار با داده ها را در نظر بگیریم ، یعنی وقتی که از ابتدا ایجاد شده است. حقوق مالکیت معنوی اظهار داشت که هر اطلاعاتی که ارائه دهنده ایجاد می کند متعلق به شرکت استخدام کننده است ، به این معنی که از طرف آنها ایجاد شده است. این همچنین بدان معنی است که ارائه دهنده باید اطمینان حاصل کند که داده ها به صورت قانونی و به درستی بدست آمده است.

به عنوان یک شرکت راه حل های داده ، Keymakr با بررسی اولین صلاحیت که در آن داده ها ایجاد می شود ، با کسب رضایت مناسب از همه افراد درگیر ، از انطباق داده ها اطمینان می دهد و تضمین می کند که داده ها می توانند از نظر قانونی برای آموزش هوش مصنوعی استفاده شوند.

همچنین توجه به این نکته حائز اهمیت است که پس از استفاده از داده ها برای آموزش مدل AI ، مشخص می شود که چه داده های خاصی به مدل کمک می کند زیرا هوش مصنوعی همه را با هم مخلوط می کند. بنابراین ، خروجی خاص تمایل به تولید آن ندارد ، به خصوص هنگام بحث در مورد میلیون ها تصویر.

با توجه به توسعه سریع ، این منطقه هنوز دستورالعمل های روشنی را برای توزیع مسئولیت ها تعیین می کند. این شبیه به پیچیدگی های اطراف خودروهای خودران است ، جایی که سؤالات مربوط به مسئولیت-خواه این راننده ، تولید کننده یا شرکت نرم افزاری باشد-هنوز هم نیاز به توزیع روشنی دارد.

در موارد دیگر ، هنگامی که یک ارائه دهنده حاشیه نویسی مجموعه داده ای برای حاشیه نویسی دریافت می کند ، فرض می کند که مشتری به طور قانونی داده ها را به دست آورده است. اگر علائم واضحی مبنی بر به دست آوردن داده ها به طور غیرقانونی وجود داشته باشد ، ارائه دهنده باید آن را گزارش دهد. با این حال ، چنین موارد ظاهری بسیار نادر است.

همچنین توجه به این نکته حائز اهمیت است که شرکت های بزرگ ، شرکت ها و مارک هایی که از شهرت خود ارزش قائل هستند ، در مورد مکان اطلاعات خود بسیار مراقب هستند ، حتی اگر از ابتدا ایجاد نشده باشد اما از منابع قانونی دیگر گرفته شود.

به طور خلاصه ، مسئولیت هر شرکت کننده در فرآیند کار داده ها به توافق بستگی دارد. شما می توانید این فرایند بخشی از “زنجیره پایداری” گسترده تر را در نظر بگیرید ، جایی که هر یک از شرکت کنندگان نقش مهمی در حفظ معیارهای قانونی و اخلاقی دارند.

چه تصورات غلط در مورد پایان عقب توسعه هوش مصنوعی وجود دارد؟

تصور غلط عمده در مورد توسعه هوش مصنوعی این است که مدل های هوش مصنوعی به طور مشابه با موتورهای جستجو ، جمع آوری و جمع آوری اطلاعات برای ارائه به کاربران بر اساس دانش آموخته کار می کنند. با این حال ، مدل های هوش مصنوعی ، به ویژه مدل های زبان ، اغلب بر اساس احتمالات به جای درک واقعی عمل می کنند. آنها با استفاده از الگوهای مشاهده شده در داده های قبلی ، کلمات یا اصطلاحات را بر اساس احتمال آماری پیش بینی می کنند. هوش مصنوعی چیزی را نمی داند ؛ این احتمالات را استخراج می کند ، حدس می زند و تنظیم می کند.

علاوه بر این ، بسیاری تصور می کنند که آموزش هوش مصنوعی به مجموعه داده های عظیمی نیاز دارد ، اما بخش اعظم آنچه که هوش مصنوعی باید تشخیص دهد-مانند سگ ها ، گربه ها یا انسان ها-در حال حاضر به خوبی تثبیت شده است. اکنون تمرکز بر بهبود دقت و مدل های پالایش به جای اختراع مجدد قابلیت های تشخیص است. بخش اعظم توسعه AI امروزه به جای شروع از ابتدا ، آخرین شکاف های کوچک را در دقت می چرخاند.

چالش های اخلاقی و چگونگی قانون AI اتحادیه اروپا و کاهش مقررات ایالات متحده بر بازار جهانی هوش مصنوعی تأثیر خواهد گذاشت

هنگام بحث در مورد اخلاق و قانونی بودن کار با داده ها ، این مهم است که به وضوح بفهمیم چه چیزی “اخلاقی” هوش مصنوعی را تعریف می کند.

بزرگترین چالش اخلاقی که امروزه در هوش مصنوعی با آن روبرو هستند ، تعیین آنچه برای انجام یا آموزش AI غیرقابل قبول تلقی می شود. یک اجماع گسترده وجود دارد که هوش مصنوعی اخلاقی باید به جای آسیب رساندن به انسان کمک کند و از فریب خودداری کند. با این حال ، سیستم های هوش مصنوعی می توانند خطایی یا “توهم” ایجاد کنند ، که به چالش می کشد که آیا این اشتباهات به عنوان اطلاعاتی یا آسیب ها واجد شرایط هستند.

اخلاق هوش مصنوعی یک بحث اساسی با سازمانهایی است که مانند یونسکو درگیر می شوند – با اصول اصلی پیرامون قابلیت شنیدن و قابلیت ردیابی از خروجی ها

چارچوب های قانونی پیرامون دسترسی به داده ها و آموزش هوش مصنوعی نقش مهمی در شکل دادن به چشم انداز اخلاقی هوش مصنوعی دارند. کشورهایی که محدودیت کمتری در استفاده از داده ها دارند ، داده های آموزشی در دسترس تر را امکان پذیر می کنند ، در حالی که کشورهایی که قوانین سخت تر داده ها دارند ، در دسترس بودن داده ها را برای آموزش AI محدود می کنند.

به عنوان مثال ، اروپا ، که قانون هوش مصنوعی را به تصویب رسانده است ، و ایالات متحده ، که بسیاری از مقررات هوش مصنوعی را به عقب برگرداند ، رویکردهای متضاد را ارائه می دهد که نشانگر چشم انداز جهانی فعلی است.

قانون اتحادیه اروپا AI به طور قابل توجهی بر شرکت های فعالیت در اروپا تأثیر می گذارد. این یک چارچوب نظارتی دقیق را اجرا می کند و استفاده از مشاغل یا توسعه مدل های خاص هوش مصنوعی را برای مشاغل دشوار می کند. شرکت ها باید مجوزهای خاصی را برای همکاری با برخی از فناوری های خاص بدست آورند و در بسیاری موارد ، این آیین نامه به طور مؤثر رعایت این قوانین برای مشاغل کوچکتر بسیار دشوار است.

در نتیجه ، برخی از استارتاپ ها ممکن است تصمیم بگیرند که اروپا را ترک کنند یا از فعالیت در آنجا خودداری کنند ، مشابه تأثیر مشاهده شده با مقررات رمزنگاری. شرکت های بزرگتر که می توانند سرمایه گذاری مورد نیاز برای برآورده کردن الزامات مربوط به انطباق را داشته باشند ، ممکن است سازگار شوند. با این وجود ، این عمل می تواند نوآوری هوش مصنوعی را به نفع بازارهایی مانند ایالات متحده یا اسرائیل از اروپا خارج کند ، جایی که مقررات سختگیرانه تر هستند.

تصمیم ایالات متحده برای سرمایه گذاری منابع اصلی در توسعه هوش مصنوعی با محدودیت های کمتری نیز می تواند اشکالاتی داشته باشد اما از تنوع بیشتری در بازار دعوت می کند. در حالی که اتحادیه اروپا بر ایمنی و انطباق نظارتی تمرکز دارد ، ایالات متحده احتمالاً آزمایش ریسک پذیری و برآمدگی بیشتری را تقویت می کند.