بهبود یافته است مدل های زبان بزرگ (LLM) اغلب پدیدار می شوند، و در حالی که راه حل های مبتنی بر ابر راحتی را ارائه می دهند، اجرای LLM به صورت محلی چندین مزیت از جمله حفظ حریم خصوصی، دسترسی آفلاین، و کنترل بیشتر بر داده ها و سفارشی سازی مدل را ارائه می دهد.

اجرای LLM به صورت محلی چندین مزیت قانع کننده دارد:

- حریم خصوصی: کنترل کامل بر روی داده های خود را حفظ کنید و اطمینان حاصل کنید که اطلاعات حساس در محیط محلی شما باقی می مانند و به سرورهای خارجی منتقل نمی شوند.

- دسترسی آفلاین: از LLM ها حتی بدون اتصال به اینترنت استفاده کنید، که آنها را برای موقعیت هایی که اتصال محدود یا غیرقابل اعتماد است ایده آل می کند.

- سفارشی سازی: مدلها را برای هماهنگی با وظایف و اولویتهای خاص تنظیم کنید و عملکرد را برای موارد استفاده منحصربهفرد شما بهینه کنید.

- مقرون به صرفه بودن: از هزینههای اشتراک مکرر مرتبط با راهحلهای مبتنی بر ابر خودداری کنید، که به طور بالقوه باعث صرفهجویی در هزینهها در بلندمدت میشود.

این تفکیک به بررسی برخی از ابزارهایی میپردازد که امکان اجرای LLM را به صورت محلی فراهم میکنند و ویژگیها، نقاط قوت و ضعف آنها را بررسی میکند تا به شما در تصمیمگیری آگاهانه بر اساس نیازهای خاص خود کمک کند.

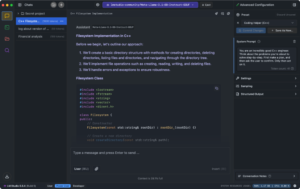

AnythingLLM یک است منبع باز برنامه هوش مصنوعی که قدرت LLM محلی را روی دسکتاپ شما قرار می دهد. این پلتفرم رایگان به کاربران راهی ساده برای گپ زدن با اسناد، اجرای عوامل هوش مصنوعی و انجام وظایف مختلف هوش مصنوعی می دهد و در عین حال همه داده ها را در دستگاه های خود ایمن نگه می دارد.

قدرت این سیستم از معماری انعطاف پذیر آن ناشی می شود. سه مؤلفه با هم کار می کنند: یک رابط مبتنی بر React برای تعامل صاف، یک سرور NodeJS Express که مدیریت سنگین پایگاه های داده برداری و ارتباطات LLM را مدیریت می کند، و یک سرور اختصاصی برای پردازش اسناد. کاربران میتوانند مدلهای AI ترجیحی خود را انتخاب کنند، خواه آنها گزینههای منبع باز را به صورت محلی اجرا میکنند یا به سرویسهای OpenAI، Azure، AWS یا سایر ارائهدهندگان متصل میشوند. این پلتفرم با انواع اسناد متعدد – از فایلهای PDF و فایلهای Word گرفته تا کل پایگاههای کد کار میکند – و آن را برای نیازهای مختلف سازگار میکند.

چیزی که AnythingLLM را قانع کننده می کند تمرکز آن بر کنترل کاربر و حفظ حریم خصوصی است. برخلاف جایگزینهای مبتنی بر ابر که دادهها را به سرورهای خارجی ارسال میکنند، AnythingLLM همه چیز را بهطور پیشفرض به صورت محلی پردازش میکند. برای تیمهایی که به راهحلهای قویتری نیاز دارند، نسخه Docker از چندین کاربر با مجوزهای سفارشی پشتیبانی میکند، در حالی که همچنان امنیت را حفظ میکند. سازمانهایی که از AnythingLLM استفاده میکنند، میتوانند با استفاده از مدلهای رایگان و منبع باز، از هزینههای API که اغلب به خدمات ابری مربوط میشود، صرف نظر کنند.

ویژگی های کلیدی Anything LLM:

- سیستم پردازش محلی که تمام داده ها را روی دستگاه شما نگه می دارد

- چارچوب پشتیبانی چند مدلی که به ارائه دهندگان مختلف هوش مصنوعی متصل می شود

- موتور تجزیه و تحلیل اسناد، فایل های PDF، فایل های Word و کد را مدیریت می کند

- ساخته شده در عوامل هوش مصنوعی برای اتوماسیون وظایف و تعامل وب

- API توسعه دهنده که ادغام ها و برنامه های افزودنی سفارشی را فعال می کند

GPT4All همچنین مدل های زبان بزرگ را مستقیماً روی دستگاه شما اجرا می کند. این پلتفرم پردازش هوش مصنوعی را روی سخت افزار خود قرار می دهد، بدون اینکه داده ای از سیستم شما خارج شود. نسخه رایگان به کاربران امکان دسترسی به بیش از 1000 مدل منبع باز از جمله LLaMa و میسترال.

این سیستم بر روی سخت افزار استاندارد مصرف کننده – سری Mac M، AMD و NVIDIA کار می کند. برای کارکرد نیازی به اتصال اینترنت ندارد و برای استفاده آفلاین ایده آل است. از طریق ویژگی LocalDocs، کاربران می توانند فایل های شخصی را تجزیه و تحلیل کنند و پایگاه های دانش را به طور کامل بر روی دستگاه خود بسازند. این پلتفرم از هر دو CPU و پردازش GPUانطباق با منابع سخت افزاری موجود.

نسخه سازمانی ماهانه 25 دلار برای هر دستگاه هزینه دارد و ویژگی هایی را برای استقرار تجاری اضافه می کند. سازمانها اتوماسیون گردش کار را از طریق عوامل سفارشی، یکپارچهسازی زیرساخت فناوری اطلاعات و پشتیبانی مستقیم از Nomic AI، شرکتی که پشت آن قرار دارد، دریافت میکنند. تمرکز بر پردازش محلی به این معنی است که دادههای شرکت در محدودههای سازمانی باقی میمانند و ضمن حفظ قابلیتهای هوش مصنوعی، الزامات امنیتی را برآورده میکنند.

ویژگی های کلیدی GPT4All:

- به طور کامل بر روی سخت افزار محلی بدون نیاز به اتصال ابری اجرا می شود

- دسترسی به بیش از 1000 مدل زبان منبع باز

- تجزیه و تحلیل اسناد داخلی از طریق LocalDocs

- عملیات آفلاین را کامل کنید

- ابزارهای استقرار سازمانی و پشتیبانی

Olama LLM ها را مستقیماً روی رایانه شما دانلود، مدیریت و اجرا می کند. این ابزار منبع باز یک محیط ایزوله حاوی تمام اجزای مدل – وزن ها، پیکربندی ها و وابستگی ها – ایجاد می کند که به شما امکان می دهد هوش مصنوعی را بدون خدمات ابری اجرا کنید.

این سیستم از طریق خط فرمان و رابط های گرافیکی کار می کند و از macOS، Linux و Windows پشتیبانی می کند. کاربران مدل هایی را از کتابخانه Ollama می کشند، از جمله Llama 3.2 برای کارهای متنی، Mistral برای تولید کد، Code Llama برای برنامه نویسی، LLaVA برای پردازش تصویر، و فی-3 برای کار علمی هر مدل در محیط مخصوص به خود اجرا می شود و جابجایی بین ابزارهای هوش مصنوعی مختلف را برای کارهای خاص آسان می کند.

سازمانهایی که از Ollama استفاده میکنند هزینههای ابری را کاهش دادهاند و در عین حال کنترل دادهها را بهبود میبخشند. این ابزار به چت ربات های محلی، پروژه های تحقیقاتی و برنامه های کاربردی هوش مصنوعی که داده های حساس را مدیریت می کنند، قدرت می دهد. توسعهدهندگان آن را با سیستمهای CMS و CRM موجود ادغام میکنند و قابلیتهای هوش مصنوعی را اضافه میکنند و در عین حال دادهها را در سایت نگه میدارند. با حذف وابستگی های ابری، تیم ها به صورت آفلاین کار می کنند و الزامات حریم خصوصی مانند GDPR را بدون به خطر انداختن عملکرد هوش مصنوعی برآورده می کنند.

ویژگی های کلیدی اولاما:

- سیستم مدیریت مدل کامل برای دانلود و کنترل نسخه

- خط فرمان و رابط های بصری برای سبک های کاری مختلف

- پشتیبانی از چندین پلتفرم و سیستم عامل

- محیط های ایزوله برای هر مدل هوش مصنوعی

- ادغام مستقیم با سیستم های تجاری

LM Studio یک برنامه دسکتاپ است که به شما امکان می دهد مدل های زبان هوش مصنوعی را مستقیماً روی رایانه خود اجرا کنید. از طریق رابط آن، کاربران مدلها را از Hugging Face پیدا، دانلود و اجرا میکنند و در عین حال تمام دادهها را نگه میدارند و پردازش میکنند.

این سیستم به عنوان یک فضای کاری کامل هوش مصنوعی عمل می کند. سرور داخلی آن از API OpenAI تقلید می کند و به شما امکان می دهد هوش مصنوعی محلی را به هر ابزاری که با OpenAI کار می کند متصل کنید. این پلتفرم از انواع مدل های اصلی مانند Llama 3.2، Mistral، Phi، Gemma، DeepSeek و Qwen 2.5 پشتیبانی می کند. کاربران اسناد را بکشید و رها کنید تا با آنها چت کنند RAG (بازیابی نسل افزوده)، با تمام پردازش اسناد در دستگاه آنها باقی می ماند. این رابط به شما امکان میدهد تا نحوه اجرای مدلها، از جمله استفاده از GPU و اعلانهای سیستم را دقیق تنظیم کنید.

اجرای AI به صورت محلی نیاز به سخت افزار قوی دارد. کامپیوتر شما برای کار با این مدل ها به قدرت CPU، رم و حافظه کافی نیاز دارد. کاربران در هنگام اجرای چندین مدل به طور همزمان، برخی کاهش سرعت عملکرد را گزارش می دهند. اما برای تیم هایی که حریم خصوصی داده ها را در اولویت قرار می دهند، LM Studio وابستگی های ابری را به طور کامل حذف می کند. این سیستم هیچ اطلاعات کاربری را جمع آوری نمی کند و تمام تعاملات را آفلاین نگه می دارد. در حالی که برای استفاده شخصی رایگان است، کسب و کارها باید مستقیماً برای صدور مجوز تجاری با LM Studio تماس بگیرند.

ویژگی های کلیدی LM Studio:

- کشف و دانلود مدل داخلی از Hugging Face

- سرور API سازگار با OpenAI برای ادغام هوش مصنوعی محلی

- قابلیت چت سند با پردازش RAG

- عملیات آفلاین کامل بدون جمع آوری داده

- گزینه های پیکربندی مدل ریزدانه

Jan یک جایگزین رایگان و منبع باز برای ChatGPT به شما می دهد که کاملاً آفلاین اجرا می شود. این پلت فرم دسکتاپ به شما امکان می دهد مدل های محبوب هوش مصنوعی مانند Llama 3، Gemma و Mistral را دانلود کنید تا در رایانه شخصی خود اجرا شوند یا در صورت نیاز به سرویس های ابری مانند OpenAI و Anthropic متصل شوید.

تمرکز سیستم بر کنترل کاربران است. سرور محلی Cortex آن با API OpenAI مطابقت دارد و باعث می شود با ابزارهایی مانند Continue.dev و Open Interpreter کار کند. کاربران تمام دادههای خود را در یک «پوشه داده Jan» محلی ذخیره میکنند، بدون اینکه اطلاعاتی از دستگاهشان خارج شود، مگر اینکه استفاده از خدمات ابری را انتخاب کنند. این پلتفرم مانند VSCode یا Obsidian کار می کند – می توانید آن را با افزودنی های سفارشی برای مطابقت با نیازهای خود گسترش دهید. این بر روی مک، ویندوز و لینوکس اجرا می شود و از پردازنده های گرافیکی NVIDIA (CUDA)، AMD (Vulkan) و Intel Arc پشتیبانی می کند.

Jan همه چیز را حول مالکیت کاربر می سازد. کد تحت AGPLv3 منبع باز می ماند و به هر کسی اجازه می دهد آن را بازرسی یا تغییر دهد. در حالی که پلتفرم میتواند دادههای استفاده ناشناس را به اشتراک بگذارد، این کاملا اختیاری است. کاربران مدل هایی را برای اجرا انتخاب می کنند و کنترل کامل بر داده ها و تعاملات خود را حفظ می کنند. برای تیم هایی که خواهان پشتیبانی مستقیم هستند، Jan یک انجمن Discord و مخزن GitHub فعال دارد که در آن کاربران به شکل دادن به توسعه پلت فرم کمک می کنند.

ویژگی های کلیدی Jan:

- عملیات آفلاین کامل با اجرای مدل محلی

- API سازگار با OpenAI از طریق سرور Cortex

- پشتیبانی از هر دو مدل هوش مصنوعی محلی و ابری

- سیستم افزودنی برای ویژگی های سفارشی

- پشتیبانی از چند GPU در تولید کنندگان بزرگ

تصویر: موزیلا

Llamafile مدل های هوش مصنوعی را به فایل های اجرایی منفرد تبدیل می کند. این سازندگان موزیلا پروژه llama.cpp را با جهان وطنی Libc برای ایجاد برنامه های مستقل که هوش مصنوعی را بدون نصب یا راه اندازی اجرا می کنند.

این سیستم وزنهای مدل را بهعنوان بایگانیهای ZIP فشردهنشده برای دسترسی مستقیم به GPU تراز میکند. این ویژگی های CPU شما را در زمان اجرا شناسایی می کند تا عملکرد مطلوبی داشته باشد و در پردازنده های Intel و AMD کار کند. این کد، قطعات مخصوص GPU را در صورت تقاضا با استفاده از کامپایلرهای سیستم شما کامپایل می کند. این طرح روی macOS، Windows، Linux و BSD اجرا میشود و از پردازندههای AMD64 و ARM64 پشتیبانی میکند.

برای امنیت، Llamafile از pledge() و SECCOMP برای محدود کردن دسترسی به سیستم استفاده می کند. این با فرمت API OpenAI مطابقت دارد و آن را با کدهای موجود سازگار می کند. کاربران میتوانند وزنها را مستقیماً در فایل اجرایی جاسازی کنند یا آنها را جداگانه بارگذاری کنند، که برای پلتفرمهایی با محدودیت اندازه فایل مانند ویندوز مفید است.

ویژگی های کلیدی Llamafile:

- استقرار تک فایل بدون وابستگی خارجی

- لایه سازگاری OpenAI API داخلی

- شتاب مستقیم GPU برای Apple، NVIDIA و AMD

- پشتیبانی بین پلتفرمی برای سیستم عامل های اصلی

- بهینه سازی زمان اجرا برای معماری های مختلف CPU

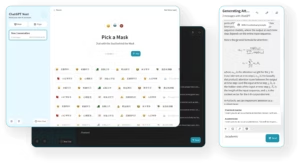

NextChat ویژگی های ChatGPT را در یک بسته منبع باز که شما کنترل می کنید قرار می دهد. این برنامه وب و دسکتاپ به چندین سرویس هوش مصنوعی – OpenAI، Google AI و Claude – متصل می شود و در عین حال همه داده ها را به صورت محلی در مرورگر شما ذخیره می کند.

این سیستم ویژگی های کلیدی که در ChatGPT استاندارد وجود ندارد را اضافه می کند. کاربران «ماسک» (مشابه GPT) را برای ساخت ابزارهای AI سفارشی با زمینه ها و تنظیمات خاص ایجاد می کنند. این پلتفرم تاریخچه چت را به صورت خودکار برای مکالمات طولانی تر فشرده می کند، از قالب بندی نشانه گذاری پشتیبانی می کند و پاسخ ها را در زمان واقعی پخش می کند. این برنامه به چندین زبان از جمله انگلیسی، چینی، ژاپنی، فرانسوی، اسپانیایی و ایتالیایی کار می کند.

کاربران به جای پرداخت برای ChatGPT Pro، کلیدهای API خود را از OpenAI، Google یا Azure متصل می کنند. آن را به صورت رایگان در یک پلتفرم ابری مانند Vercel برای مثال خصوصی، یا آن را به صورت محلی در Linux، Windows یا MacOS اجرا کنید. کاربران همچنین می توانند برای ساخت ابزارهای تخصصی از کتابخانه سریع و پشتیبانی مدل سفارشی آن استفاده کنند.

ویژگی های کلیدی NextChat:

- ذخیره سازی داده های محلی بدون ردیابی خارجی

- ایجاد ابزار AI سفارشی از طریق Mask

- پشتیبانی از چندین ارائه دهنده هوش مصنوعی و API

- استقرار با یک کلیک بر روی Vercel

- کتابخانه و الگوهای سریع داخلی