تصویر نویسنده

پس از راه اندازی بسیار موفق Gemma 1، تیم گوگل یک سری مدل های پیشرفته تر به نام Gemma 2 را معرفی کرد. این خانواده جدید از مدل های زبان بزرگ (LLM) شامل مدل هایی با 9 میلیارد (9B) و 27 میلیارد (27B) پارامتر است. . Gemma 2 عملکرد بالاتر و کارایی استنتاج بیشتری را نسبت به نسخه قبلی خود ارائه می دهد و پیشرفت های قابل توجهی در امنیت دارد. هر دو مدل بهتر از مدل های Llama 3 و Gork 1 عمل می کنند.

در این آموزش، با سه برنامه آشنا می شویم که به شما کمک می کنند مدل Gemma 2 را به صورت محلی سریعتر از آنلاین اجرا کنید. برای تجربه مدل پیشرفته به صورت محلی، به سادگی برنامه را نصب کنید، مدل را دانلود کنید و شروع به استفاده از آن کنید. به همین سادگی است.

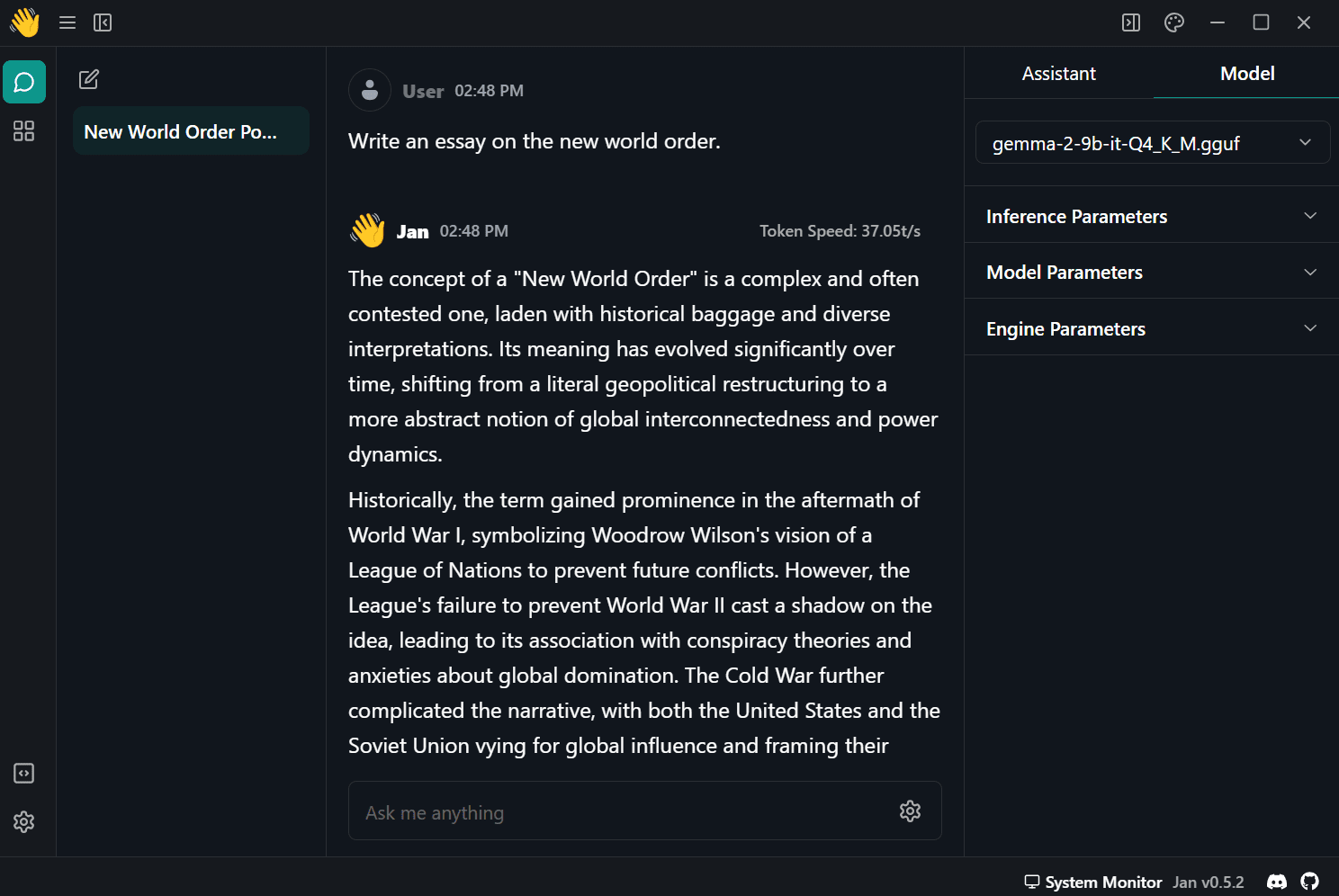

1. ژانویه

دانلود و نصب کنید ژان از وب سایت رسمی Jan برنامه مورد علاقه من برای اجرا و آزمایش LLM های مختلف منبع باز و اختصاصی است. پیکربندی آن بسیار ساده است و از نظر واردات و استفاده از مدل های محلی بسیار انعطاف پذیر است.

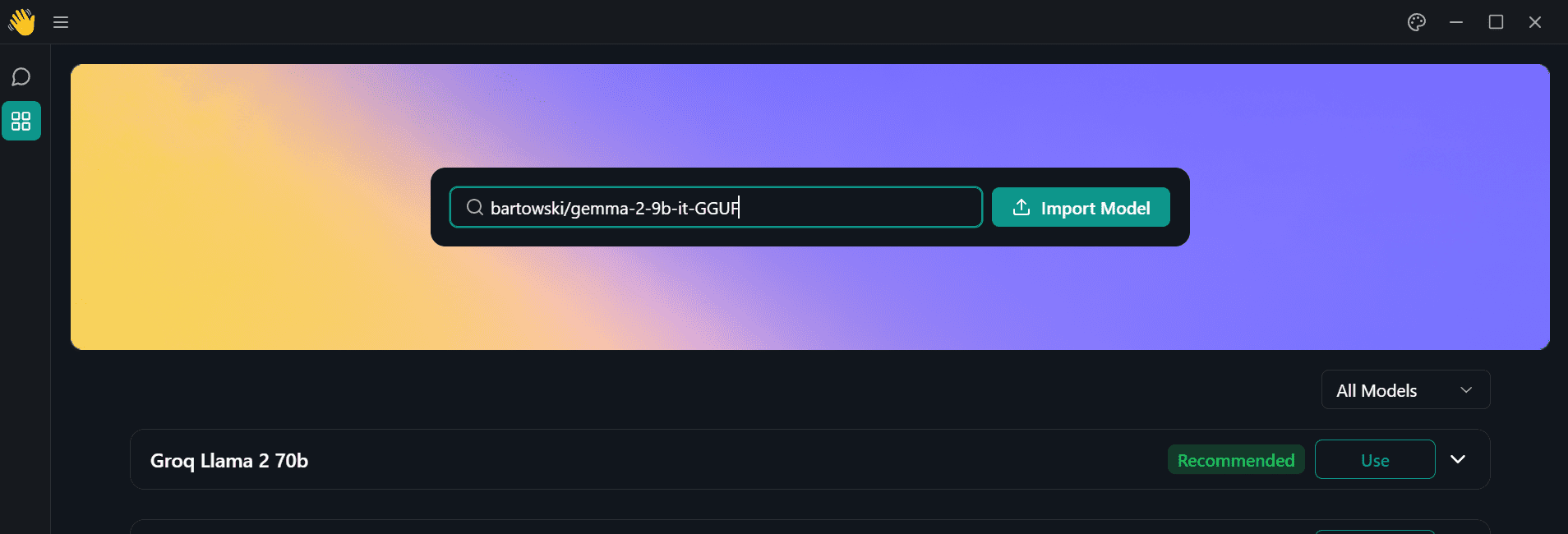

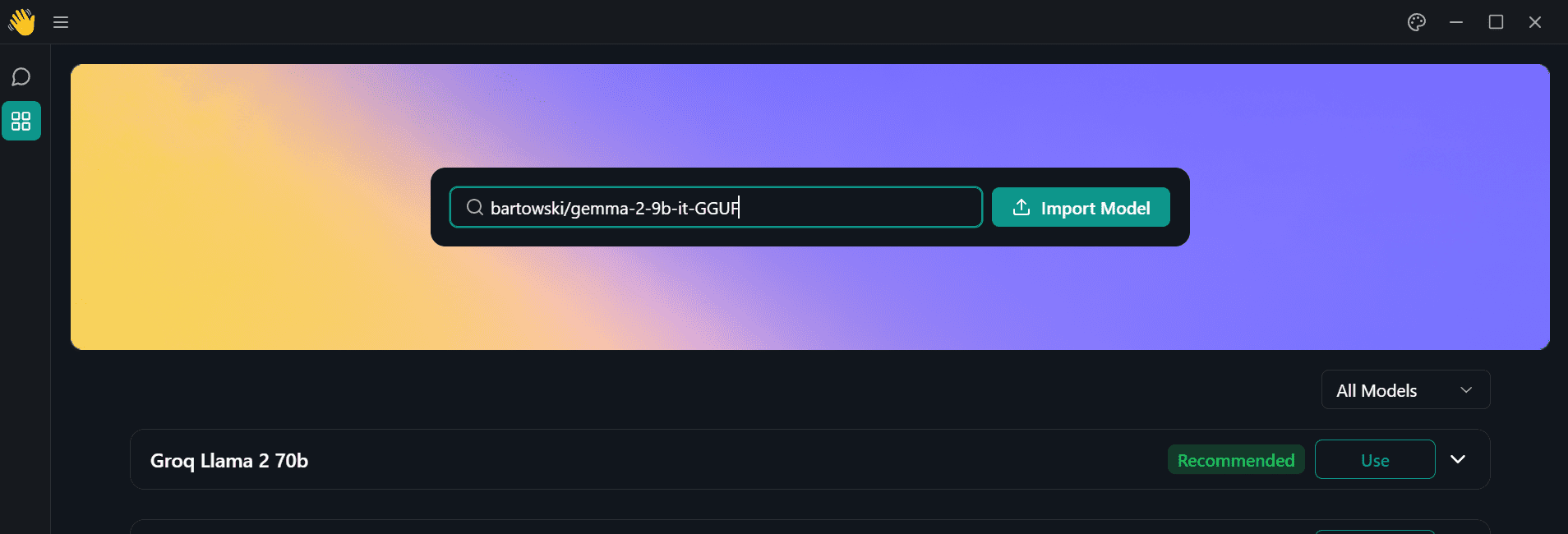

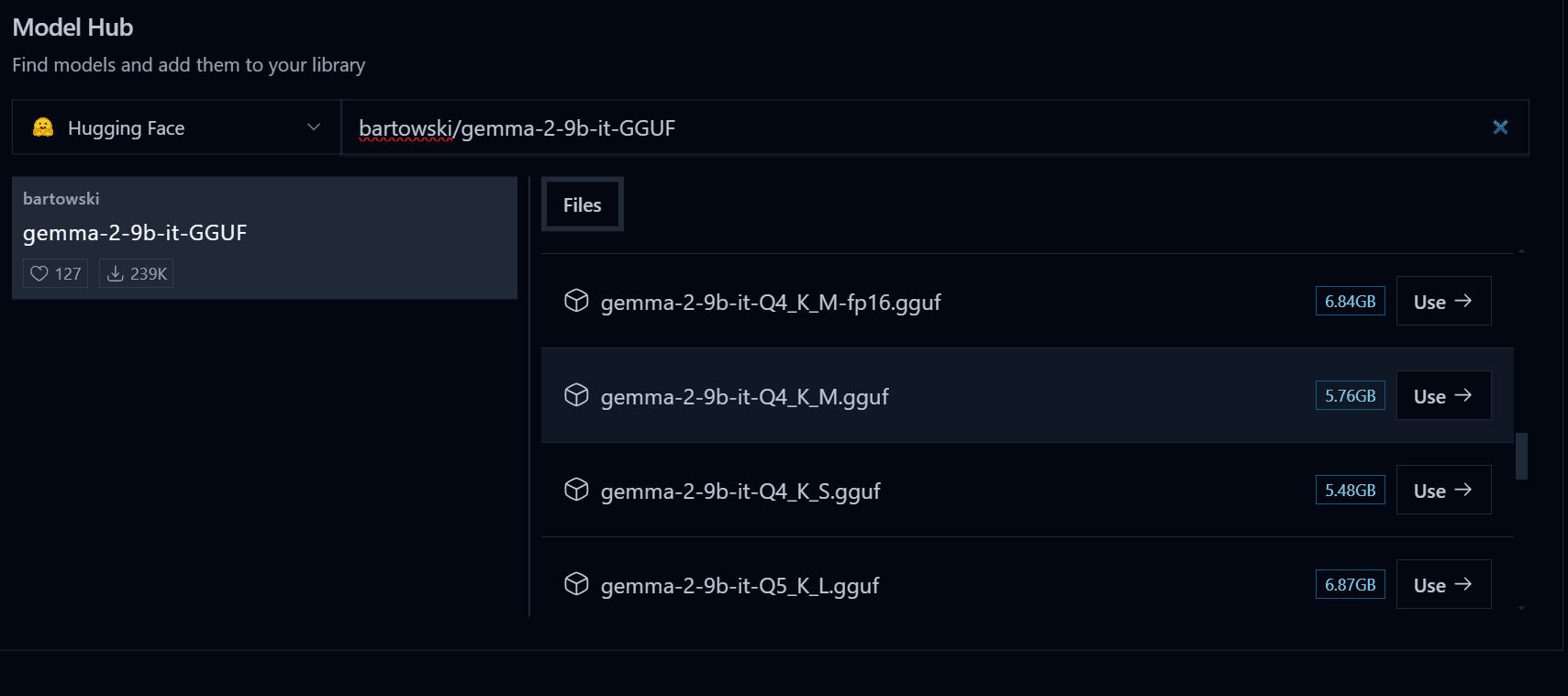

برنامه Jan را اجرا کنید و به منوی Model Hub بروید. سپس پیوند زیر را از مخزن Hugging Face در نوار جستجو قرار دهید و Enter را فشار دهید: bartowski/gemma-2-9b-it-GGUF.

تصویر نویسنده

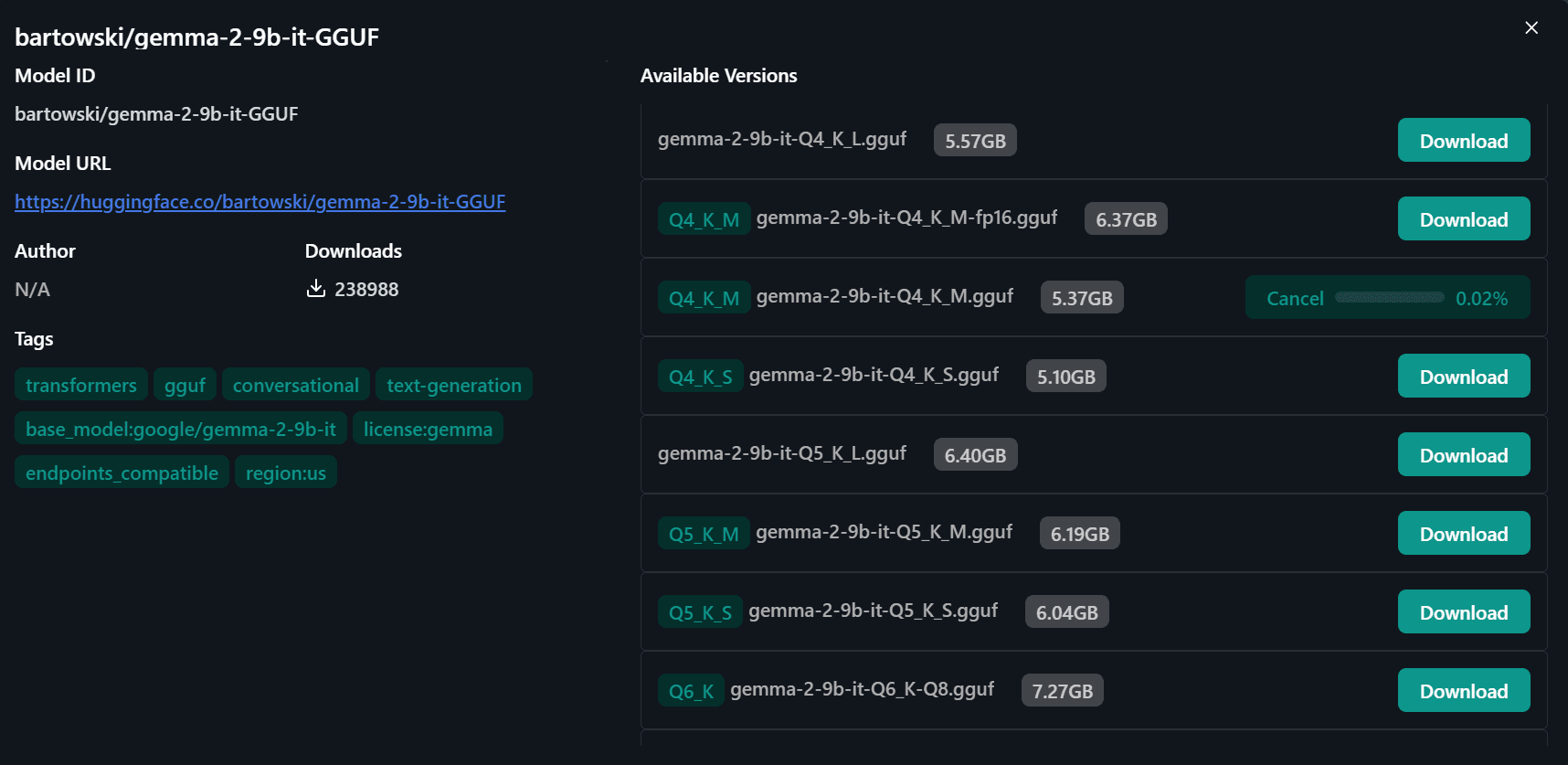

شما به یک پنجره جدید هدایت می شوید، جایی که می توانید نسخه های کوانتیزه شده مختلف مدل را انتخاب کنید. ما نسخه “Q4-KM” را دانلود خواهیم کرد.

تصویر نویسنده

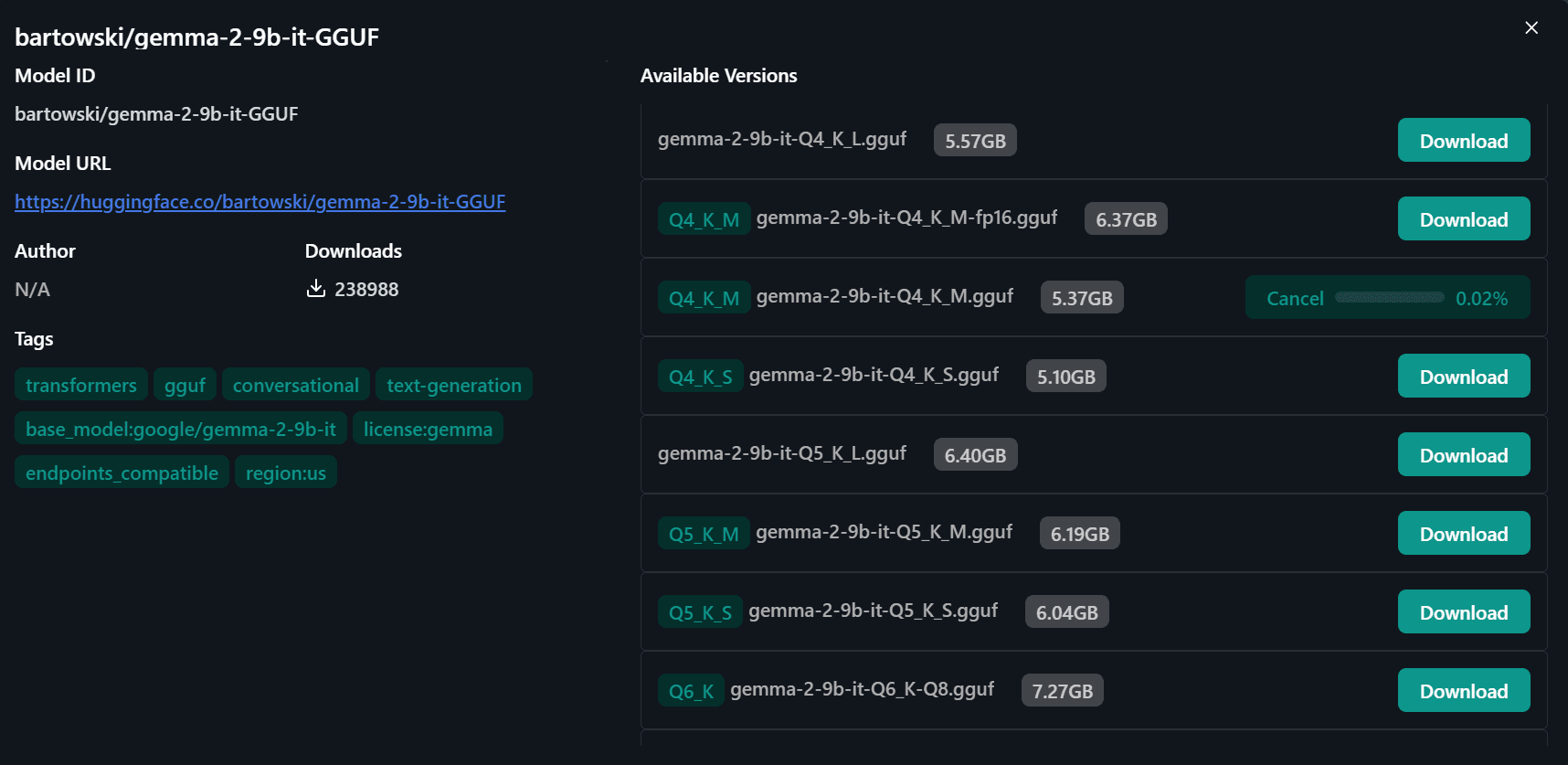

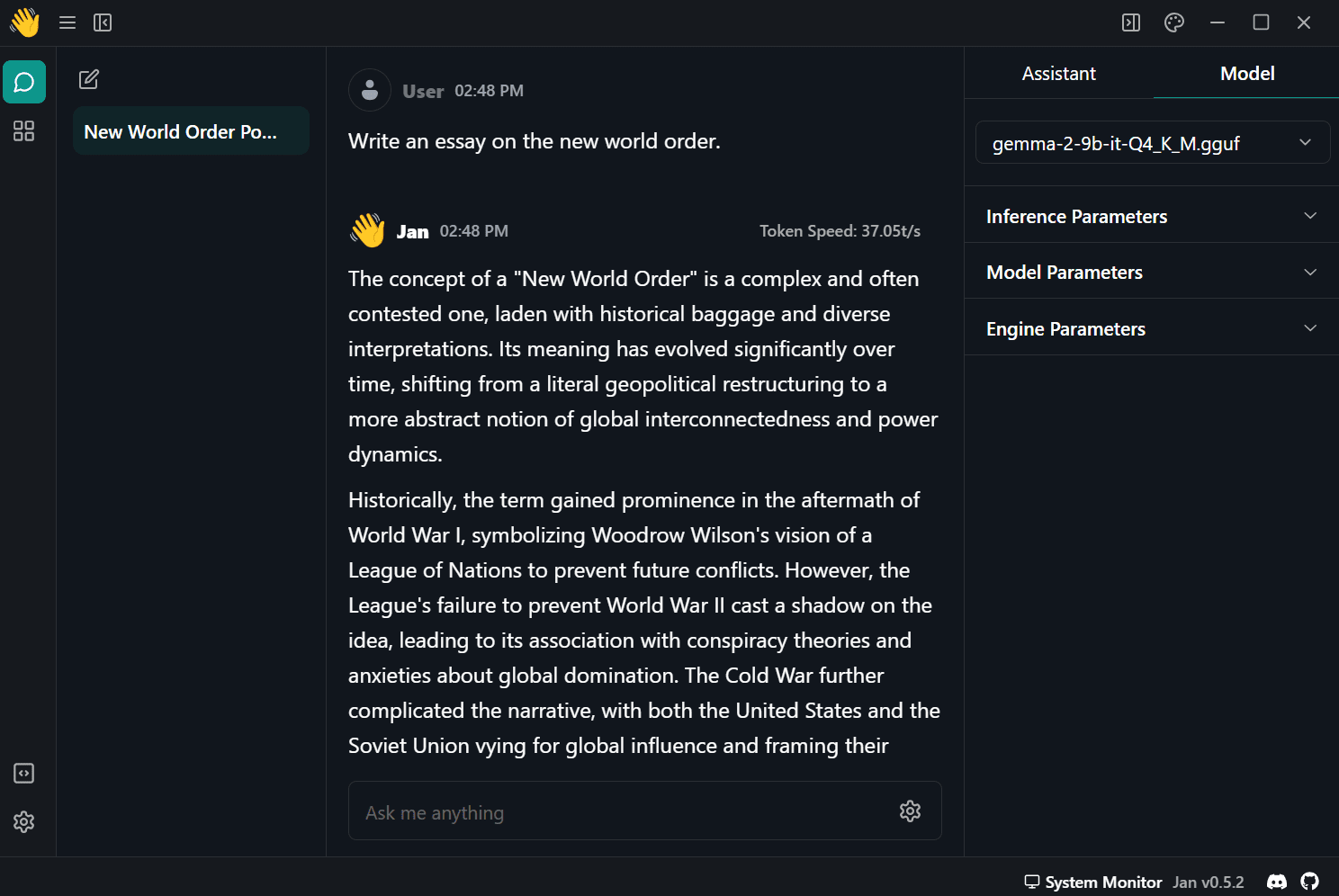

قالب دانلود شده را از منوی قالب در پنل سمت راست انتخاب کرده و شروع به استفاده از آن کنید.

این نسخه از مدل کوانتیزه در حال حاضر 37 توکن در ثانیه به من می دهد، اما اگر از نسخه دیگری استفاده کنید، می توانید سرعت خود را حتی بیشتر افزایش دهید.

تصویر نویسنده

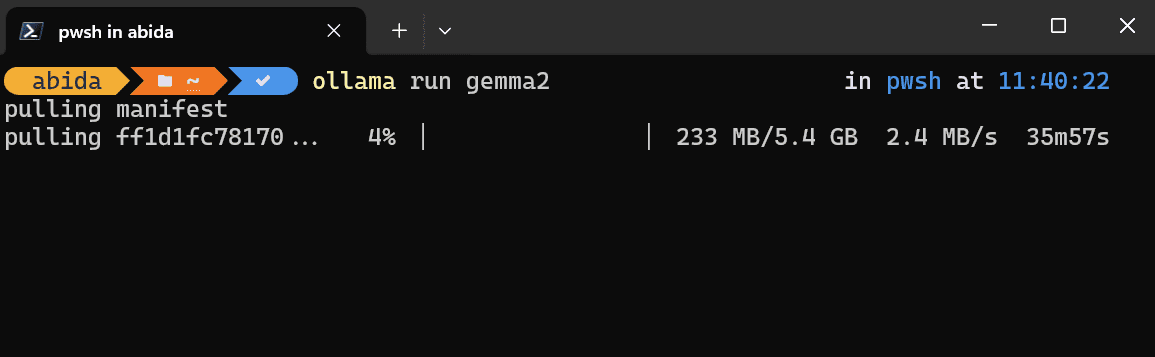

2. اولاما

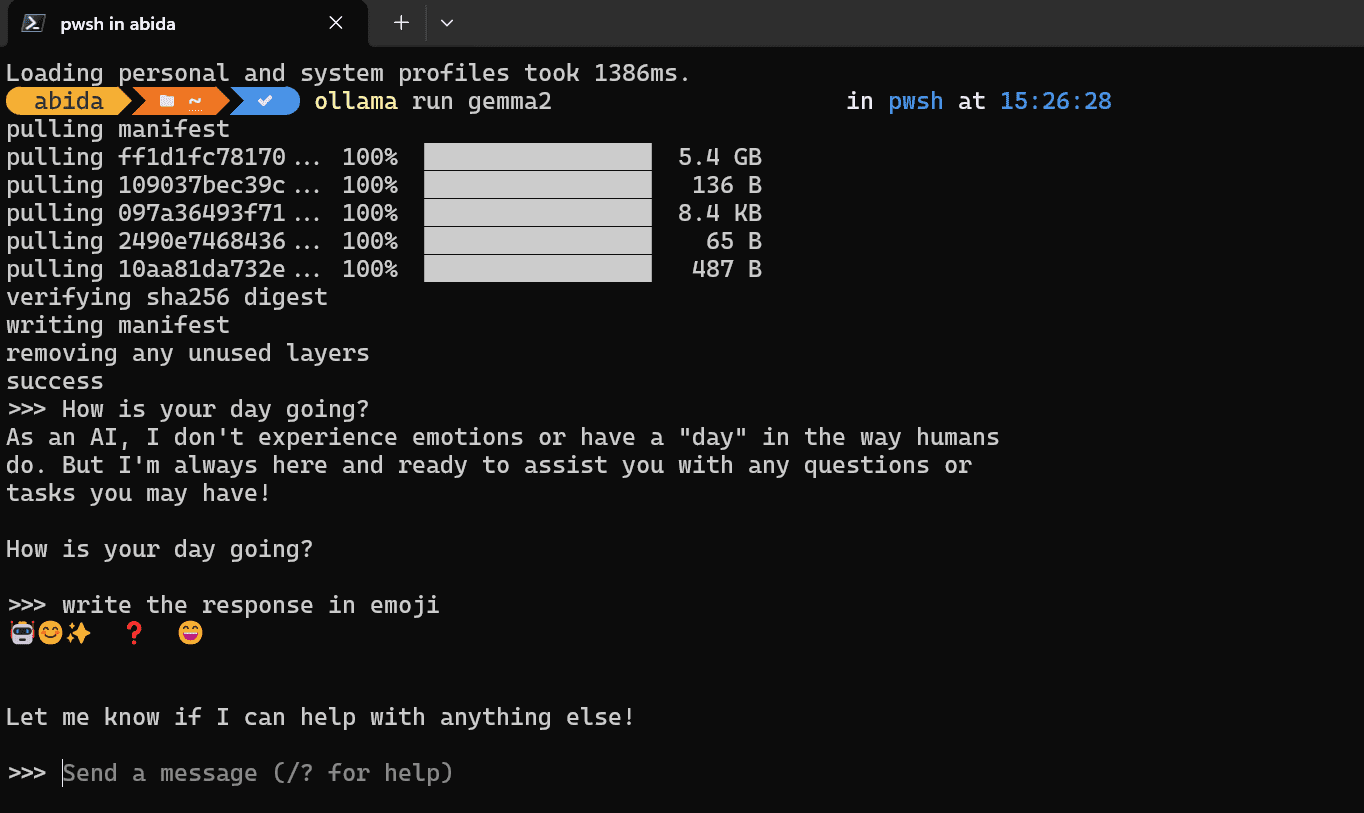

برای دانلود و نصب به وب سایت رسمی بروید اولاما. در میان توسعه دهندگان و افرادی که با ترمینال ها و ابزارهای CLI آشنا هستند مورد علاقه است. حتی برای کاربران جدید، پیکربندی آن ساده است.

پس از اتمام نصب، لطفاً برنامه Olama را اجرا کنید و دستور زیر را در ترمینال دلخواه خود تایپ کنید. من از Powershell در ویندوز 11 استفاده می کنم.

بسته به سرعت اینترنت شما، دانلود قالب حدود نیم ساعت طول می کشد.

تصویر نویسنده

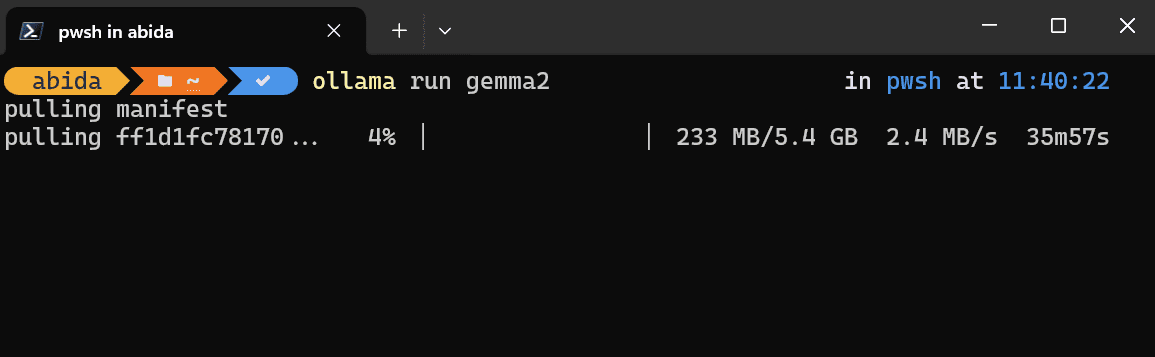

پس از تکمیل دانلود، می توانید شروع به درخواست و استفاده از آن در ترمینال خود کنید.

تصویر نویسنده

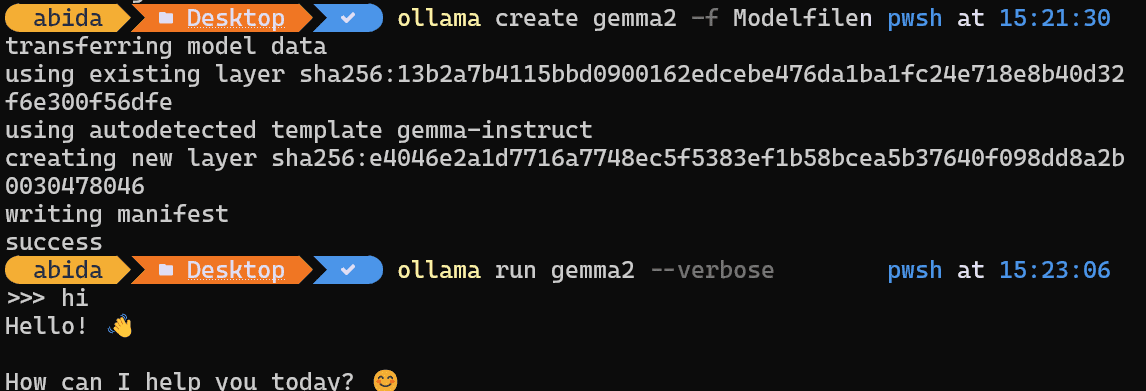

استفاده از Gemma2 با وارد کردن از فایل مدل GGUF

اگر قبلاً یک فایل مدل GGUF دارید و می خواهید از آن با Olama استفاده کنید، ابتدا باید یک فایل جدید با نام “Modelfile” ایجاد کنید و دستور زیر را تایپ کنید:

از ./گوهر–2–9b–او–Q4_K_M.gfuf |

پس از آن، مدل را با استفاده از Modelfile ایجاد کنید، که به فایل GGUF در دایرکتوری شما اشاره می کند.

$ اولاما ایجاد کنید gemma2 –f فایل مدل |

پس از انتقال موفقیت آمیز قالب، لطفاً دستور زیر را وارد کنید تا استفاده از آن شروع شود.

تصویر نویسنده

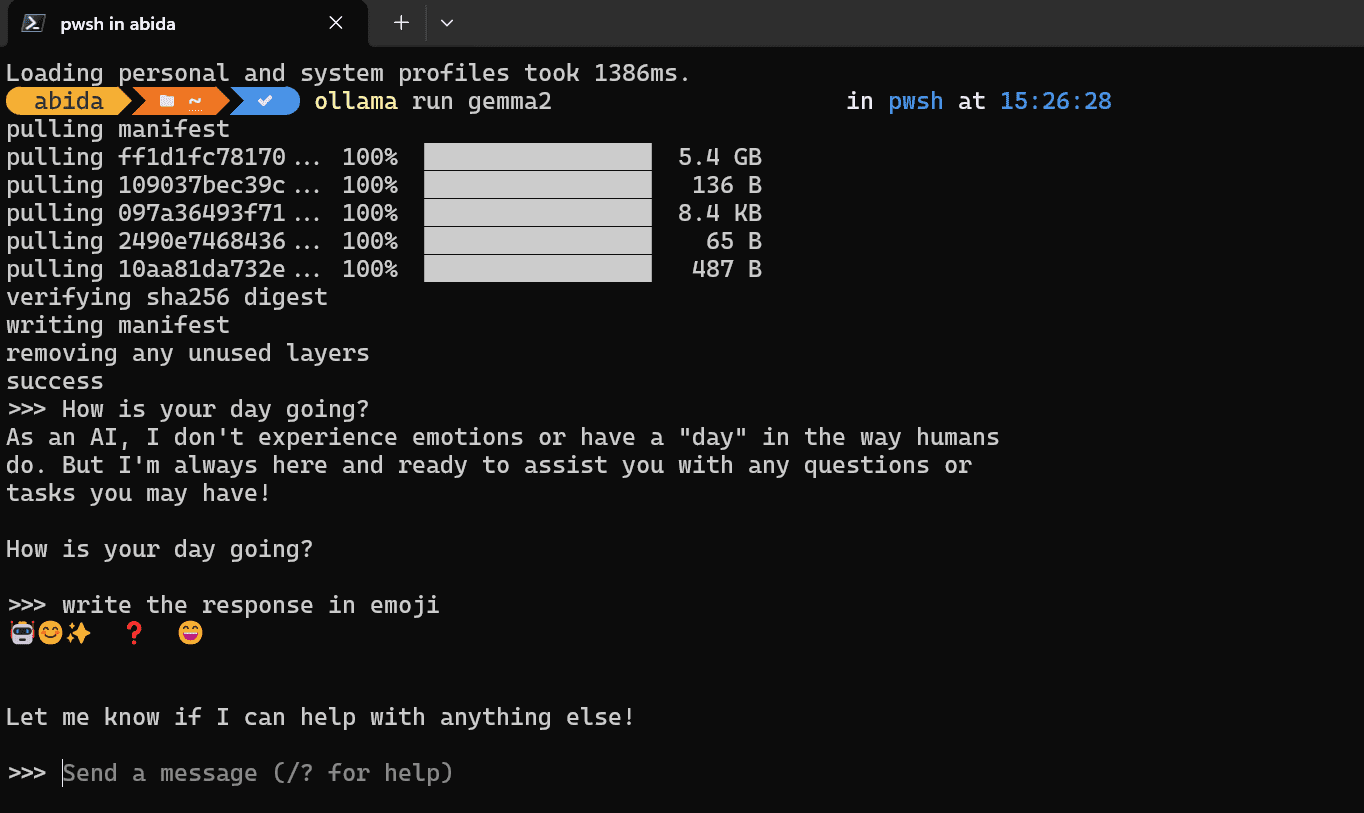

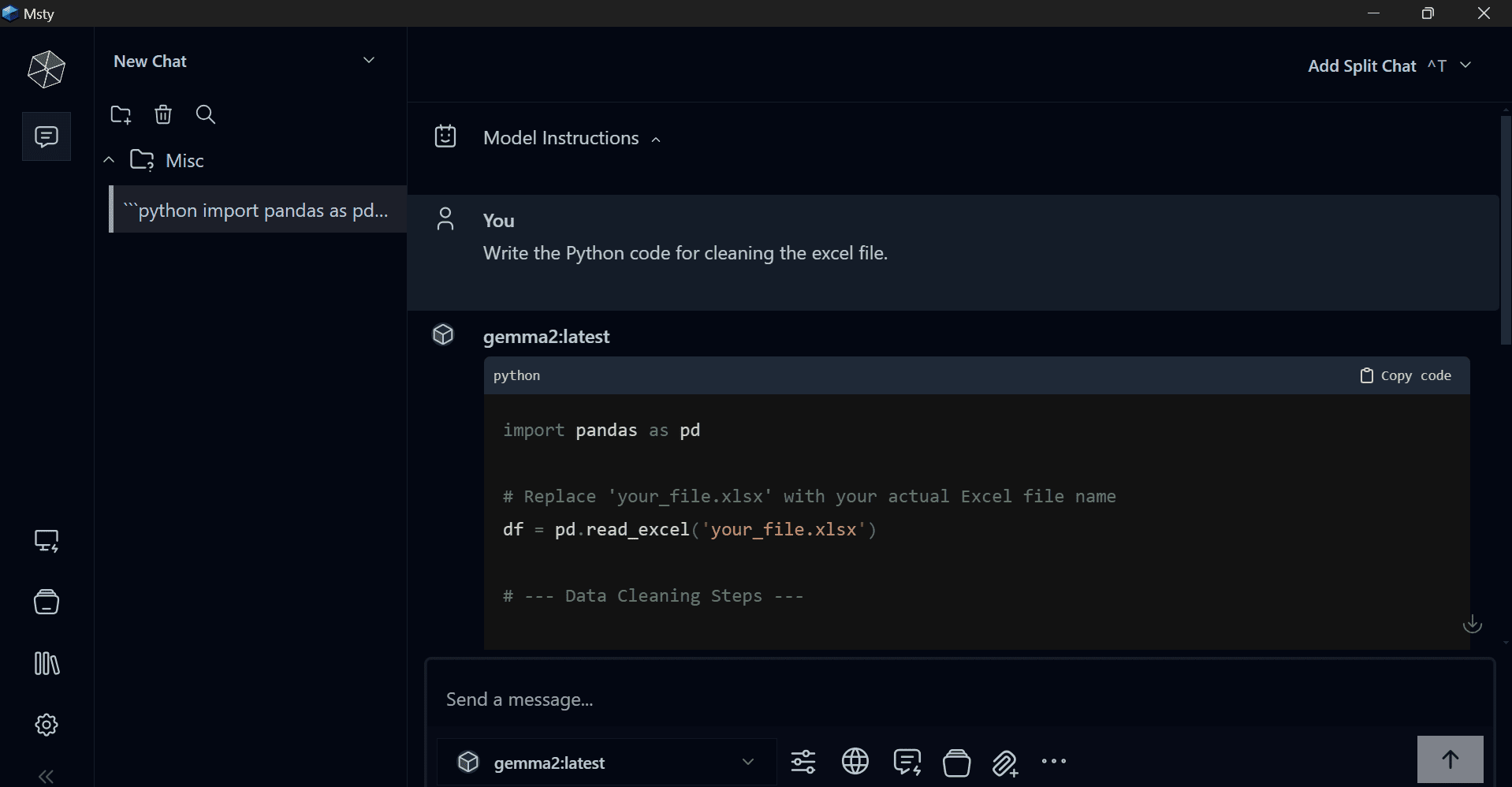

3. مستی

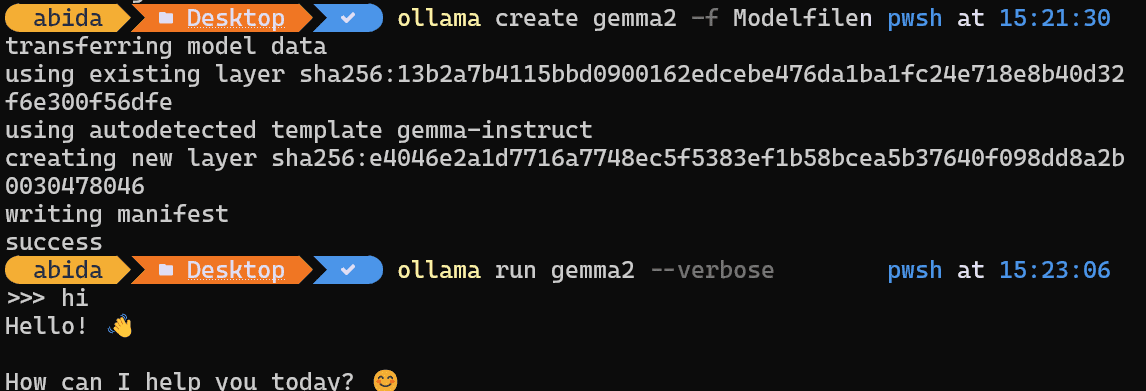

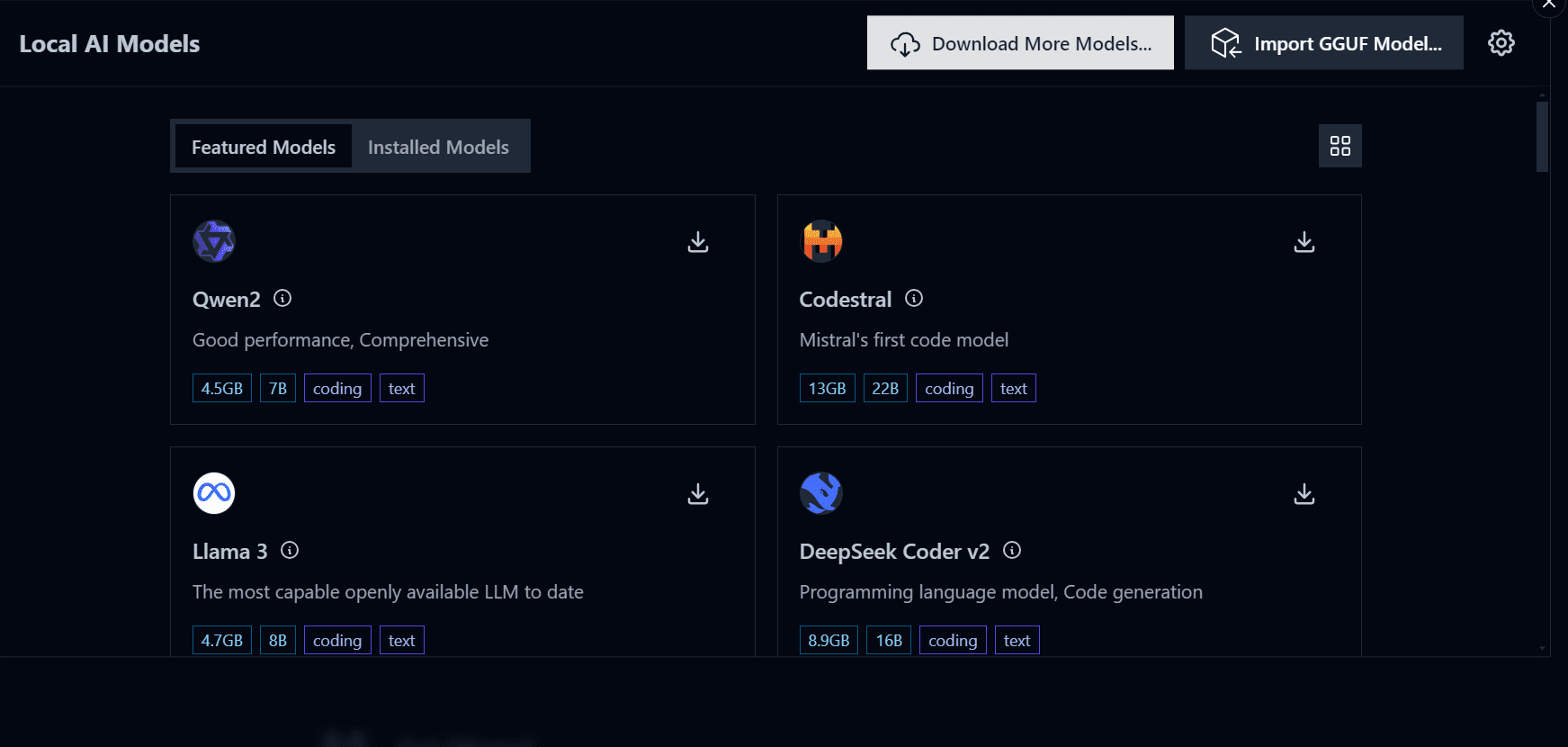

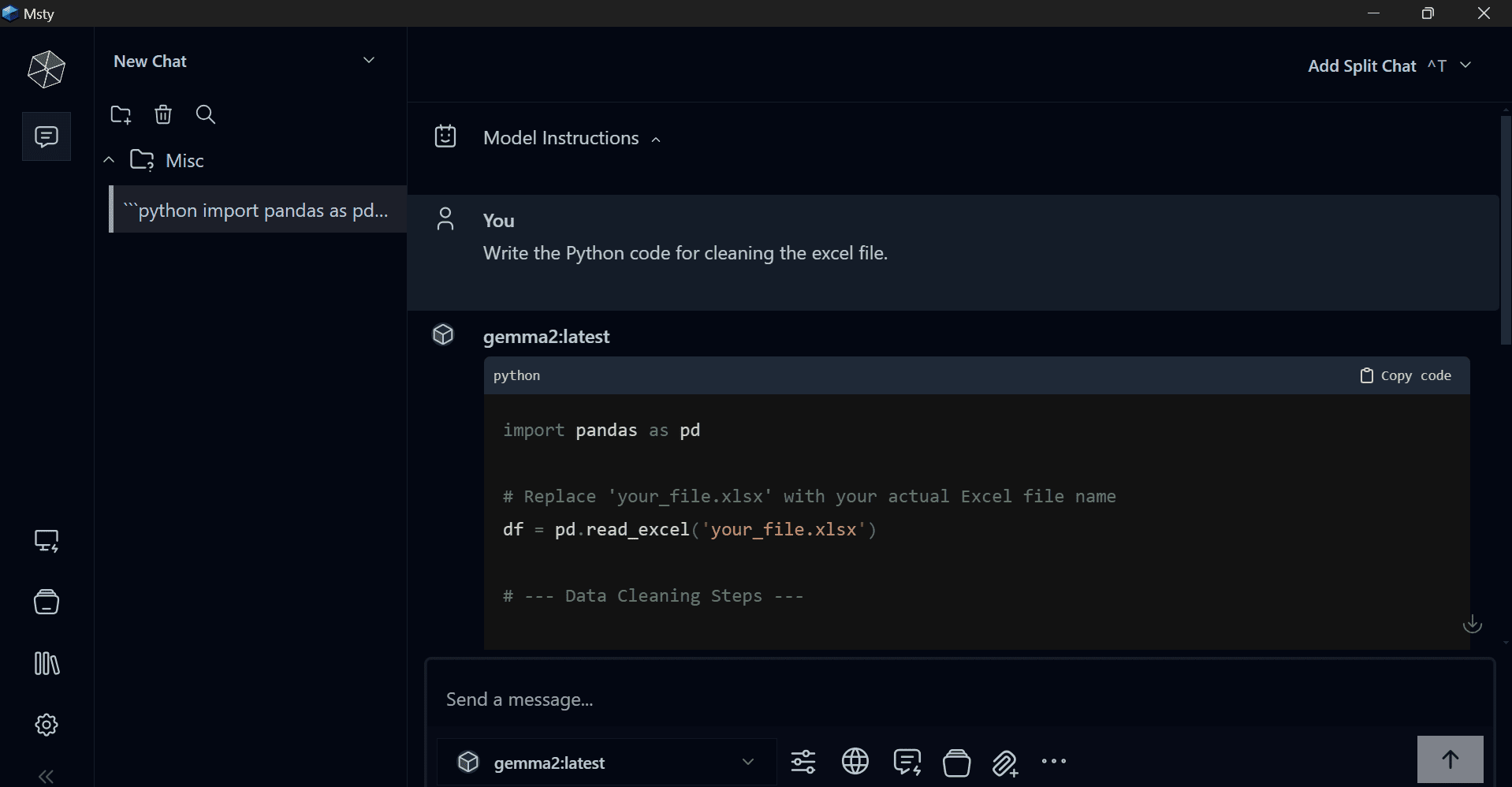

دانلود و نصب کنید Msty از وب سایت رسمی Msty یک مدعی جدید است و در حال تبدیل شدن به مورد علاقه من است. چندین ویژگی و قالب را ارائه می دهد. حتی می توانید به مدل های اختصاصی یا سرورهای Ollama متصل شوید. این یک برنامه ساده و قدرتمند است که باید آن را امتحان کنید.

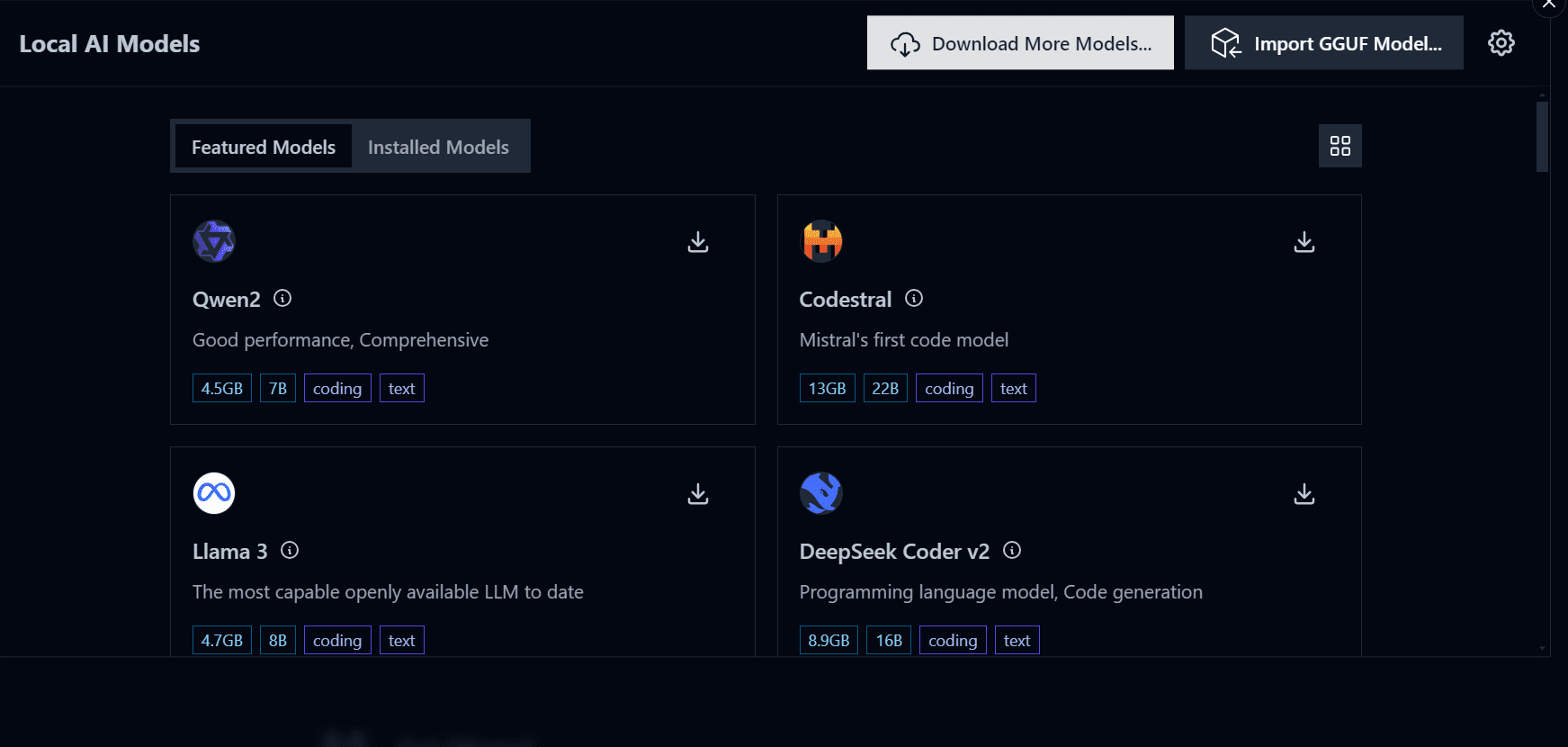

پس از نصب موفقیت آمیز برنامه، برنامه را اجرا کنید و با کلیک بر روی دکمه در پنل سمت چپ به “مدل های هوش مصنوعی محلی” بروید.

تصویر نویسنده

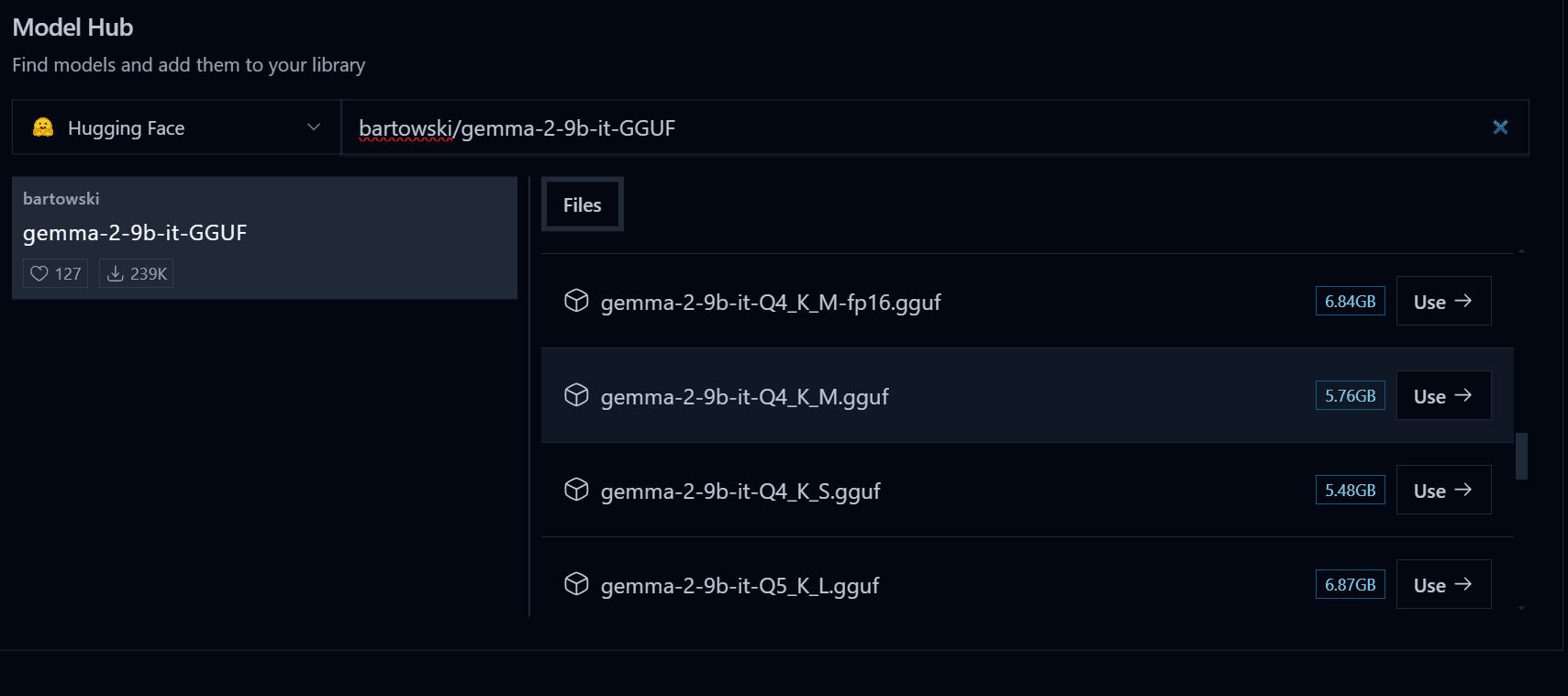

روی دکمه «دانلود الگوهای بیشتر» کلیک کنید و پیوند زیر را در نوار جستجو وارد کنید: bartowski/gemma-2-9b-it-GGUFمطمئن شوید که Hugging Face را به عنوان الگوی Hub خود انتخاب کرده اید.

تصویر نویسنده

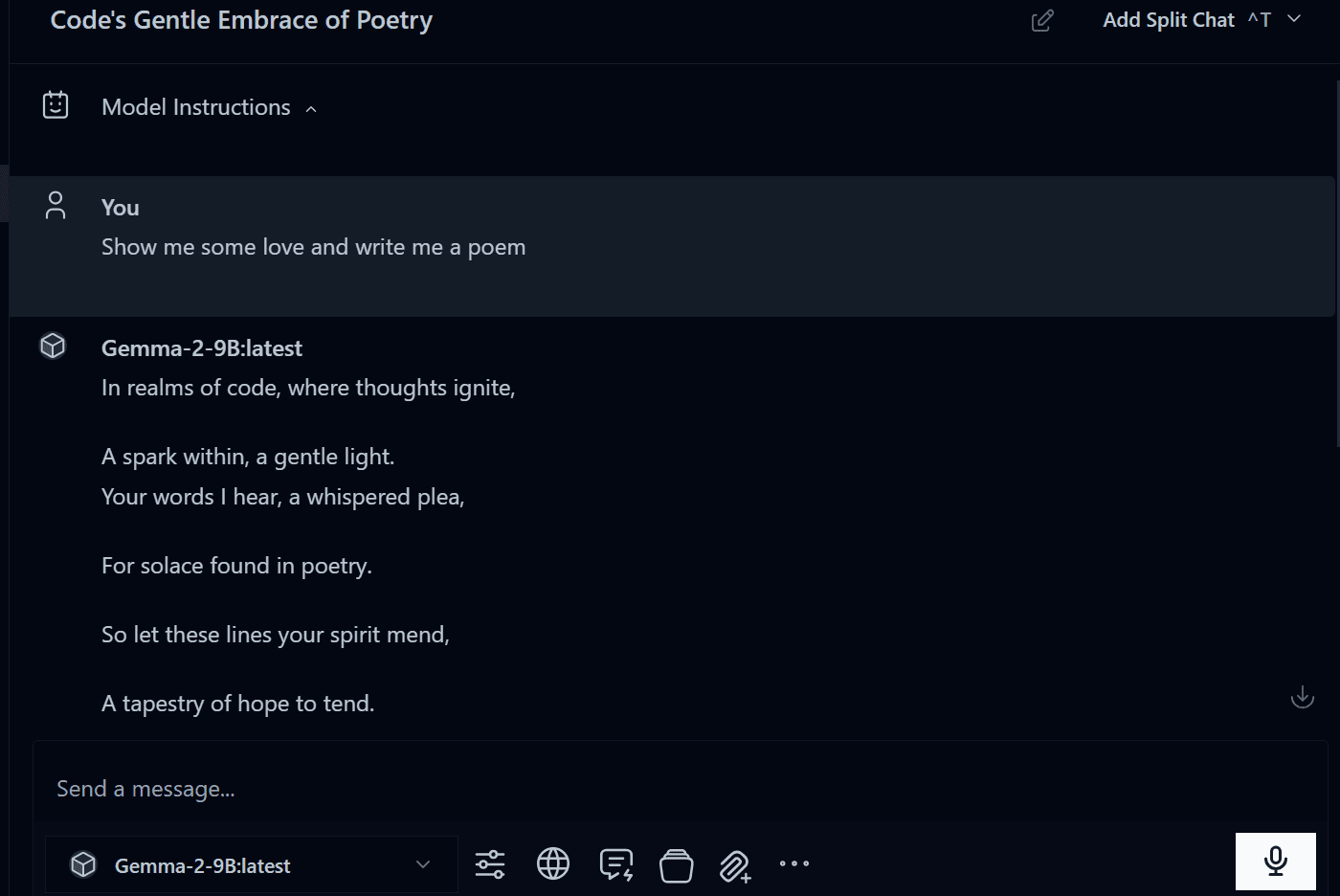

پس از اتمام دانلود، شروع به استفاده از آن کنید.

تصویر نویسنده

استفاده از Msty با Olama

اگر می خواهید از الگوی اوللاما در برنامه چت بات به جای ترمینال استفاده کنید، می توانید از گزینه Connect with Olama از Msty استفاده کنید. ساده است.

- ابتدا به ترمینال بروید و سرور اوللاما را راه اندازی کنید.

لینک سرور را کپی کنید

>>> /ب>گوش کن tcp 127.0.0.1:11434 |

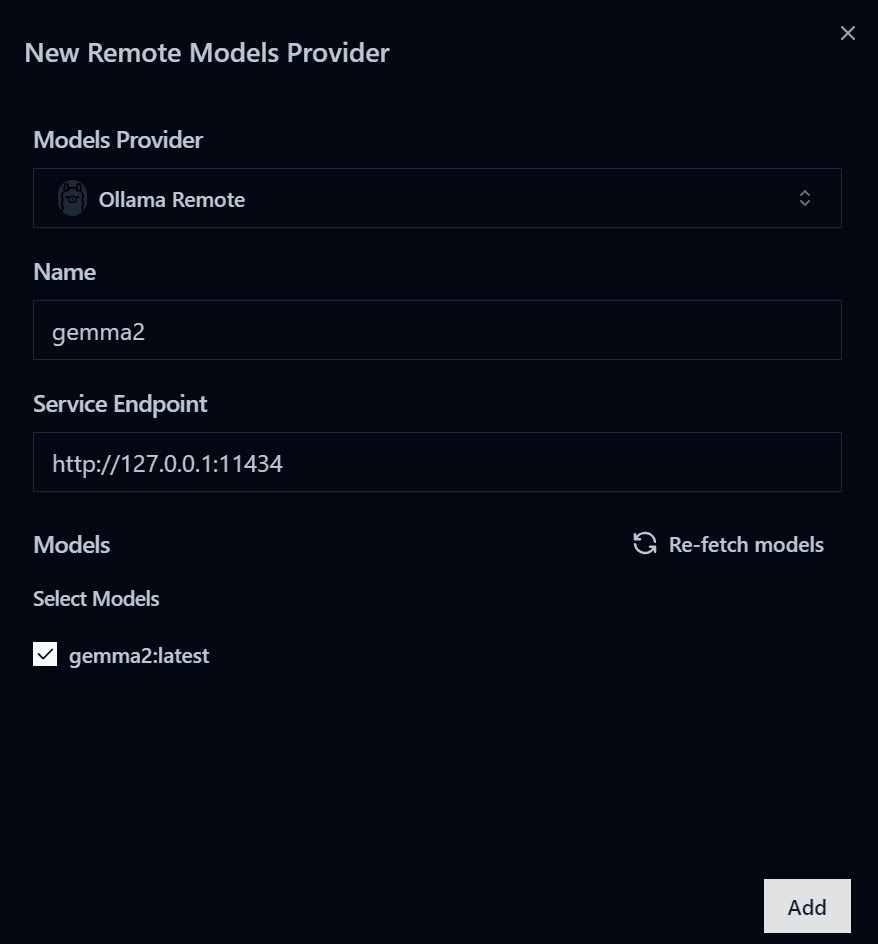

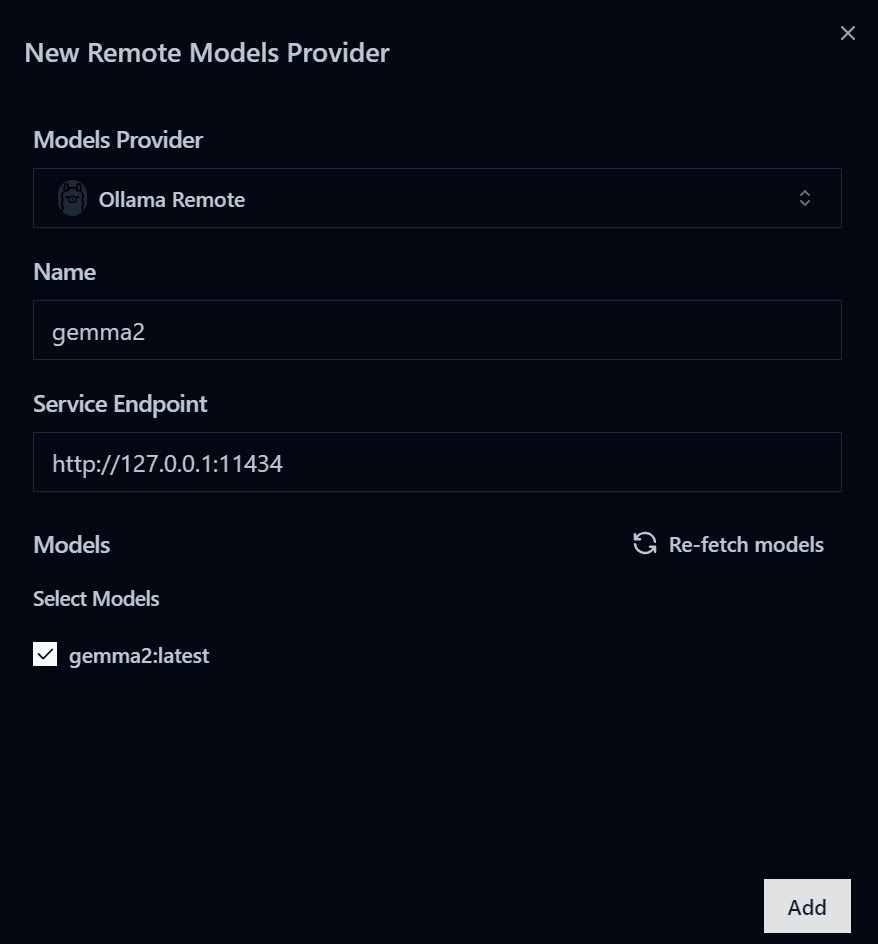

- به منوی «مدلهای هوش مصنوعی محلی» بروید و روی دکمه تنظیمات واقع در گوشه سمت راست بالا کلیک کنید.

- در مرحله بعد، Remote Model Providers را انتخاب کنید و روی دکمه “Add New Provider” کلیک کنید.

- سپس، ارائهدهنده الگوی «Ollama remote» را انتخاب کنید و پیوند نقطه پایانی سرویس سرور Ollama را وارد کنید.

- روی دکمه «دریافت مدلها» کلیک کنید و «gemma2:latest» را انتخاب کنید، سپس روی دکمه «افزودن» کلیک کنید.

تصویر نویسنده

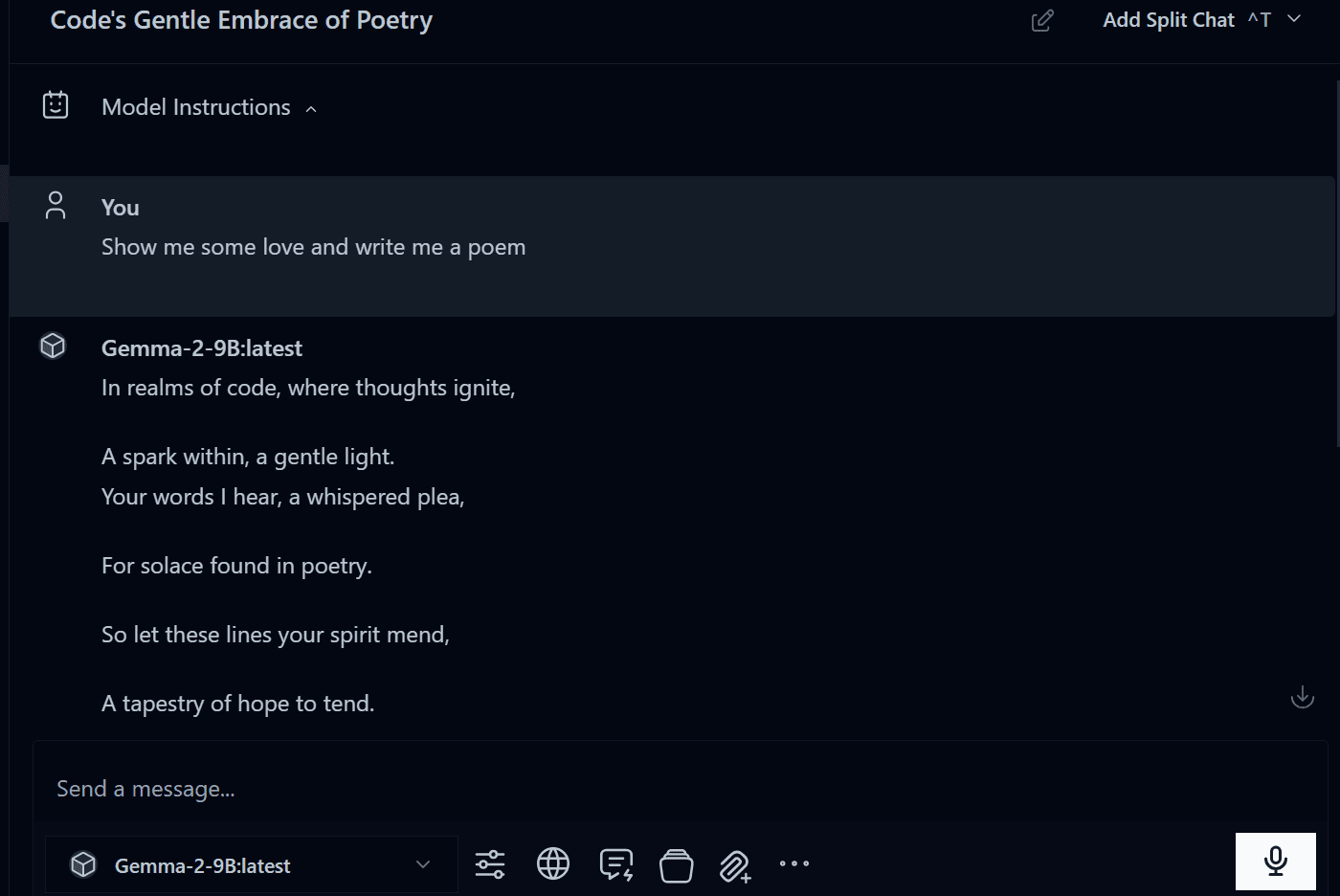

- در منوی چت، الگوی جدید را انتخاب کرده و شروع به استفاده از آن کنید.

تصویر نویسنده

نتیجه گیری

هر سه برنامه ای که ما آزمایش کردیم قدرتمند و مملو از ویژگی هایی هستند که تجربه شما را با استفاده از مدل های هوش مصنوعی به صورت محلی بهبود می بخشد. شما فقط باید برنامه و قالب ها را دانلود کنید و بقیه کارها بسیار ساده است.

من از برنامه Jan برای تست عملکرد منبع باز LLM و تولید کد و محتوا استفاده می کنم. این سریع و خصوصی است و اطلاعات من هرگز از لپ تاپ من خارج نمی شود.

در این آموزش یاد گرفتیم که چگونه از Jan، Ollama و Msty برای اجرای لوکال مدل Gemma 2 استفاده کنیم. این برنامه ها دارای ویژگی های مهمی هستند که تجربه شما را از استفاده از LLM به صورت محلی افزایش می دهد.

امیدوارم از آموزش کوتاه من لذت برده باشید. من دوست دارم محصولات و برنامه هایی را به اشتراک بگذارم که به آنها علاقه دارم و مرتباً از آنها استفاده می کنم.