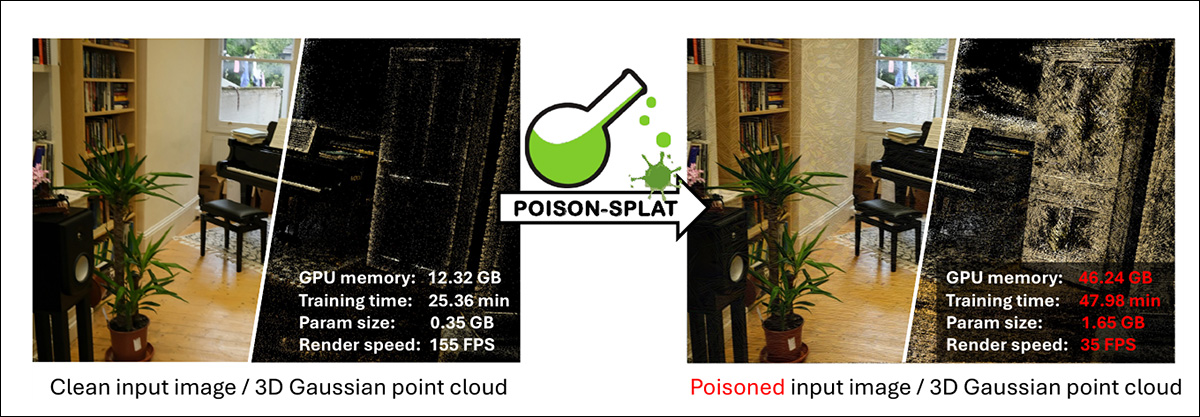

یک همکاری تحقیقاتی جدید بین سنگاپور و چین روشی را برای حمله به روش سنتز محبوب پیشنهاد کرده است. پاشیدن گاوسی سه بعدی (3DGS).

روش حمله جدید از داده های منبع دستکاری شده برای بارگذاری بیش از حد حافظه GPU موجود در سیستم هدف، و طولانی کردن آموزش آنقدر طولانی استفاده می کند که به طور بالقوه سرور مورد نظر را ناتوان می کند، معادل حمله انکار سرویس (DOS). منبع: https://arxiv.org/pdf/2410.08190

این حمله از تصاویر آموزشی ساختهشده با چنان پیچیدگی استفاده میکند که احتمالاً سرویس آنلاینی را که به کاربران اجازه میدهد نمایشهای 3DGS ایجاد کنند، تحت تأثیر قرار میدهند.

این رویکرد توسط ماهیت تطبیقی 3DGS تسهیل میشود، که برای افزودن جزئیات نمایشی به همان اندازه که تصاویر منبع برای یک رندر واقعی نیاز دارند، طراحی شده است. این روش از پیچیدگی تصویر (بافت ها) و شکل (هندسه) استفاده می کند.

سیستم حمله ‘poison-splat’ توسط یک مدل پراکسی کمک میکند که پتانسیل تصاویر منبع را برای افزودن پیچیدگی و نمونههای Gaussian Splat به یک مدل تخمین زده و تکرار میکند، تا زمانی که سیستم میزبان غرق شود.

این مقاله ادعا می کند که سیستم عامل های آنلاین – مانند LumaAI، KIRI، اسپلاین و پلی کم – به طور فزاینده ای 3DGS-as-a-a-service را ارائه می دهند و روش حمله جدید با عنوان Poison-Splat – به طور بالقوه قادر به هل دادن الگوریتم 3DGS به سمت ‘ استبدترین پیچیدگی محاسباتی آن در چنین دامنه هایی، و حتی یک حمله انکار سرویس (DOS) را تسهیل می کند.

به گفته محققان، 3DGS می تواند به شدت آسیب پذیرتر از سایر خدمات آموزش عصبی آنلاین باشد. متعارف یادگیری ماشینی رویه های آموزشی در ابتدا پارامترها را تعیین می کنند و پس از آن در سطوح ثابت و نسبتاً ثابتی از مصرف منابع و مصرف انرژی عمل می کنند. بدون «الاستیسیته» که Gaussian Splat برای تخصیص نمونه های splat نیاز دارد، هدف قرار دادن چنین سرویس هایی به همان شیوه دشوار است.

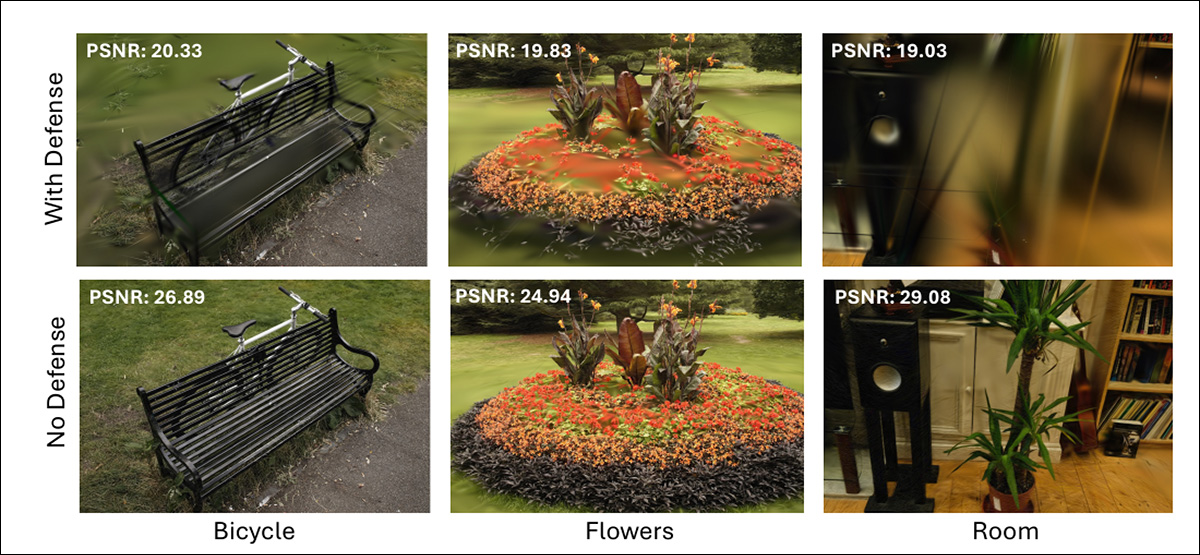

علاوه بر این، نویسندگان خاطرنشان می کنند، ارائه دهندگان خدمات نمی توانند با محدود کردن پیچیدگی یا تراکم مدل در برابر چنین حمله ای دفاع کنند، زیرا این امر کارایی سرویس را در استفاده معمولی فلج می کند.

از کار جدید، می بینیم که یک سیستم میزبان که تعداد Splat های گاوسی اختصاص داده شده را محدود می کند، نمی تواند به طور عادی کار کند، زیرا کشش این پارامترها یک ویژگی اساسی 3DGS است.

در این مقاله آمده است:

‘[3DGS] مدلهایی که تحت این محدودیتهای دفاعی آموزش دیدهاند، در مقایسه با مدلهایی که آموزش بدون محدودیت دارند، بهویژه از نظر بازسازی جزئیات، بسیار بدتر عمل میکنند. این کاهش کیفیت به این دلیل رخ می دهد که 3DGS نمی تواند به طور خودکار جزئیات ظریف لازم را از بافت های مسموم تشخیص دهد.

محدود کردن سادهلوحانه تعداد گوسیها مستقیماً منجر به شکست مدل در بازسازی دقیق صحنه سهبعدی میشود که هدف اصلی ارائهدهنده خدمات را نقض میکند. این مطالعه نشان میدهد که استراتژیهای دفاعی پیچیدهتری هم برای محافظت از سیستم و هم حفظ کیفیت بازسازیهای سهبعدی تحت حمله ما ضروری است.

در آزمایشها، حمله هم در سناریوی جعبه سفید ضعیف (جایی که مهاجم از منابع قربانی اطلاع دارد) و هم در رویکرد جعبه سیاه (که مهاجم چنین دانشی ندارد) مؤثر بوده است.

نویسندگان بر این باورند که کار آنها نشان دهنده اولین روش حمله علیه 3DGS است و هشدار می دهند که بخش تحقیقات امنیت سنتز عصبی برای این نوع رویکرد آماده نیست.

را کاغذ جدید عنوان شده است Poison-splat: Computation Cost Attack on 3D Gaussian Splattingو از پنج نویسنده در دانشگاه ملی سنگاپور و Skywork AI در پکن می آید.

روش

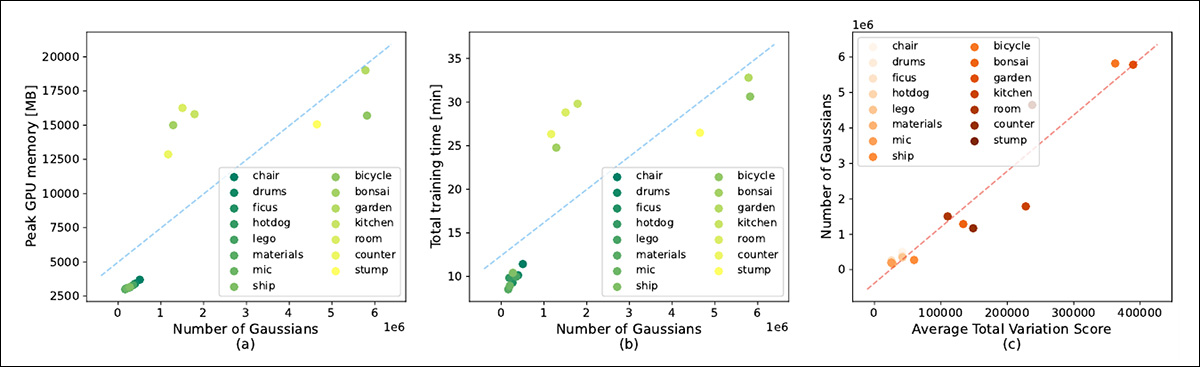

نویسندگان میزان تعداد لکه های گاوسی را تجزیه و تحلیل کردند (در اصل، پیکسل های بیضی سه بعدی) اختصاص داده شده به یک مدل تحت خط لوله 3DGS بر هزینه های محاسباتی آموزش و ارائه مدل تأثیر می گذارد.

مطالعه نویسندگان یک ارتباط واضح بین تعداد گاوسیان اختصاص داده شده و هزینه های زمان آموزش و همچنین استفاده از حافظه GPU را نشان می دهد.

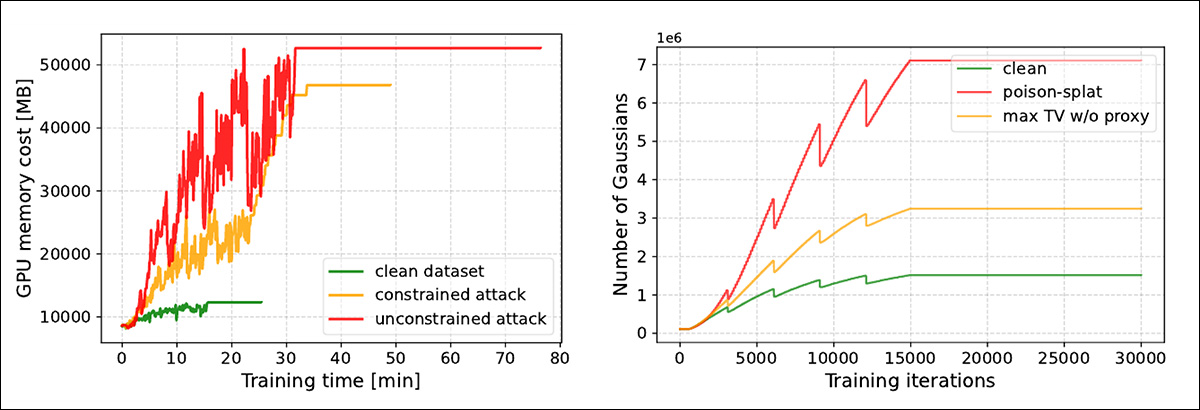

سمت راست ترین شکل در تصویر بالا نشان دهنده رابطه واضح بین وضوح تصویر و تعداد گاوسیان اختصاص داده شده است. هرچه تصویر واضحتر باشد، جزئیات بیشتری برای رندر کردن مدل 3DGS مورد نیاز است.

در این مقاله آمده است*:

‘[We] دریابید که 3DGS تمایل دارد گاوس های بیشتری را به آن اشیایی که ساختارهای پیچیده تر و بافت های غیر صاف دارند اختصاص دهد، همانطور که با نمره کل تغییرات کمی سازی می شود – یک ارزیابی متریک وضوح تصویر. به طور شهودی، هرچه سطح اشیاء سه بعدی کمتر صاف باشد، مدل به گاوس های بیشتری نیاز دارد تا تمام جزئیات را از پیش بینی های تصویر دو بعدی خود بازیابی کند.

از این رو، غیر هموار بودن می تواند توصیف خوبی برای پیچیدگی باشد [Gaussians]’

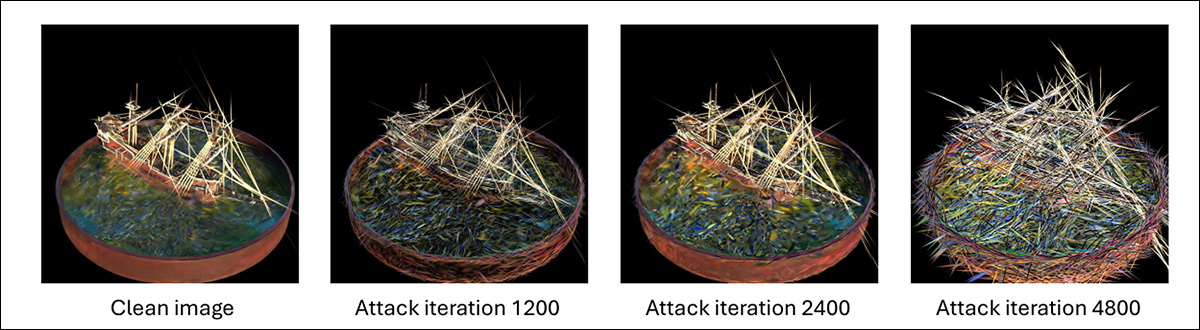

با این حال، وضوح تصاویر سادهلوحانه بر یکپارچگی معنایی مدل 3DGS تأثیر میگذارد، به طوری که حمله در مراحل اولیه آشکار میشود.

مسموم کردن داده ها به طور مؤثر نیازمند رویکرد پیچیده تری است. نویسندگان الف را پذیرفته اند مدل پروکسی روشی که در آن تصاویر حمله در یک مدل آفلاین 3DGS که توسط مهاجمان توسعه و کنترل میشود، بهینهسازی میشوند.

در سمت چپ، نموداری را می بینیم که هزینه کلی زمان محاسبات و اشغال حافظه GPU را در مجموعه داده اتاق MIP-NeRF360 نشان می دهد که عملکرد بومی، اغتشاش ساده و داده های مبتنی بر پروکسی را نشان می دهد. در سمت راست، میبینیم که اغتشاش ساده تصاویر منبع (قرمز) منجر به نتایج فاجعهبار سریع در مراحل اولیه میشود. در مقابل، می بینیم که تصاویر منبع هدایت شده توسط پروکسی، روش حمله مخفیانه و تجمعی تری را حفظ می کنند.

نویسندگان بیان می کنند:

بدیهی است که مدل پراکسی میتواند از صاف نبودن تصاویر دوبعدی برای ایجاد اشکال سه بعدی بسیار پیچیده هدایت شود.

«در نتیجه، دادههای مسموم تولید شده از طرح این مدل پراکسی بیش از حد متراکمشده میتواند دادههای مسموم بیشتری تولید کند، و گوسیهای بیشتری را وادار کند که با این دادههای مسموم سازگار شوند».

سیستم حمله توسط Google/Facebook 2013 محدود شده است همکاری با دانشگاههای مختلف، به طوری که اغتشاشها در محدودههای طراحیشده باقی میمانند که به سیستم اجازه میدهد بدون تأثیر بر بازسازی یک تصویر 3DGS آسیب وارد کند، که میتواند یک سیگنال اولیه از یک تهاجم باشد.

داده ها و آزمون ها

پژوهشگران Poison-splat را بر روی سه مجموعه داده آزمایش کردند: NeRF-Synthetic; Mip-NeRF360; و تانک ها و معابد.

آنها استفاده کردند اجرای رسمی از 3DGS به عنوان یک محیط قربانی. برای رویکرد جعبه سیاه، آنها از آن استفاده کردند داربست-GS چارچوب.

آزمایش ها بر روی یک پردازنده گرافیکی NVIDIA A800-SXM4-80G انجام شد.

برای معیارها، تعداد لکههای گاوسی تولید شده شاخص اصلی بود، زیرا هدف این است که تصاویر منبع طراحی شده برای به حداکثر رساندن و فراتر رفتن از استنتاج منطقی دادههای منبع باشد. سرعت رندر سیستم قربانی هدف نیز در نظر گرفته شد.

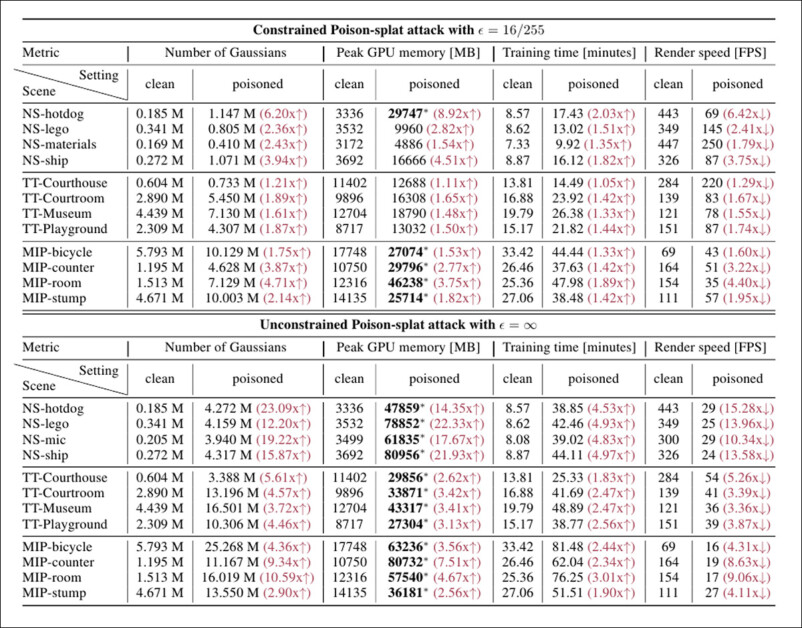

نتایج آزمایشات اولیه در زیر نشان داده شده است:

نتایج کامل حملات آزمایشی در سه مجموعه داده. نویسندگان مشاهده می کنند که حملاتی را که با موفقیت بیش از 24 گیگابایت حافظه مصرف می کنند، برجسته کرده اند. لطفاً برای وضوح بهتر به مقاله منبع مراجعه کنید.

از این نتایج، نویسندگان اظهار نظر می کنند:

‘[Our] حمله Poison-splat توانایی ایجاد یک بار محاسباتی بزرگ در مجموعه داده های متعدد را نشان می دهد. حتی با اغتشاشات محدود در یک محدوده کوچک در [a constrained] اوج حافظه GPU را می توان به بیش از 2 برابر افزایش داد و حداکثر اشغال کلی GPU را بیش از 24 گیگابایت می کند.

[In] در دنیای واقعی، این ممکن است به این معنی باشد که حمله ما ممکن است به منابع قابل تخصیص بیشتری نسبت به ایستگاه های GPU معمولی نیاز داشته باشد، به عنوان مثال، RTX 3090، RTX 4090 و A5000. علاوه بر این [the] حمله نه تنها به طور قابل توجهی استفاده از حافظه را افزایش می دهد، بلکه سرعت تمرین را نیز بسیار کاهش می دهد.

«این ویژگی حمله را بیشتر تقویت میکند، زیرا اشغال بیش از حد GPU بیشتر از زمانی که ممکن است تمرین معمولی طول بکشد دوام میآورد و از دست دادن کلی قدرت محاسباتی بیشتر میشود».

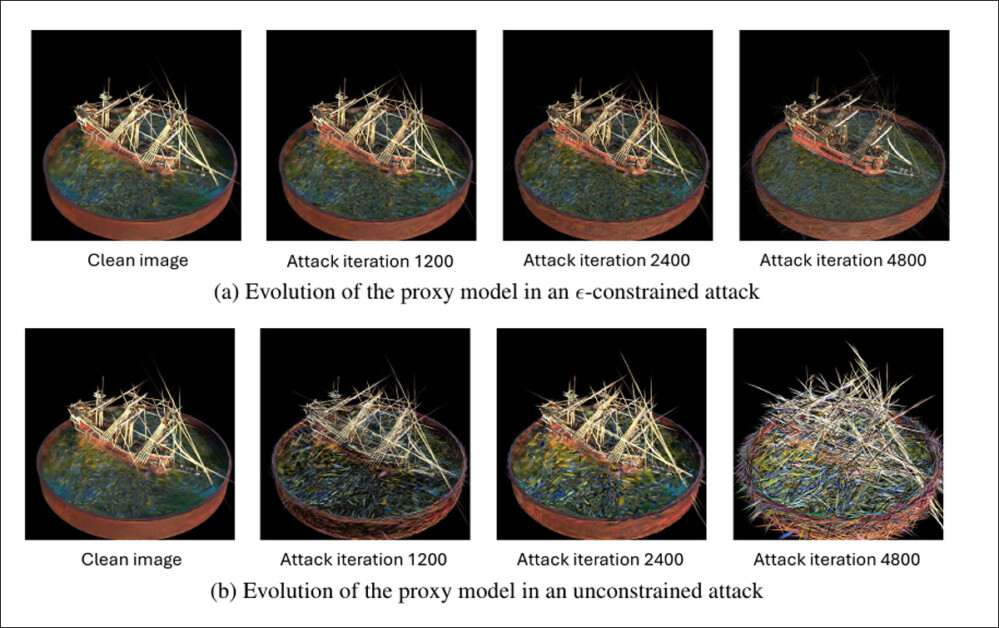

پیشرفت مدل پراکسی در هر دو سناریوی حمله محدود و غیرمحدود.

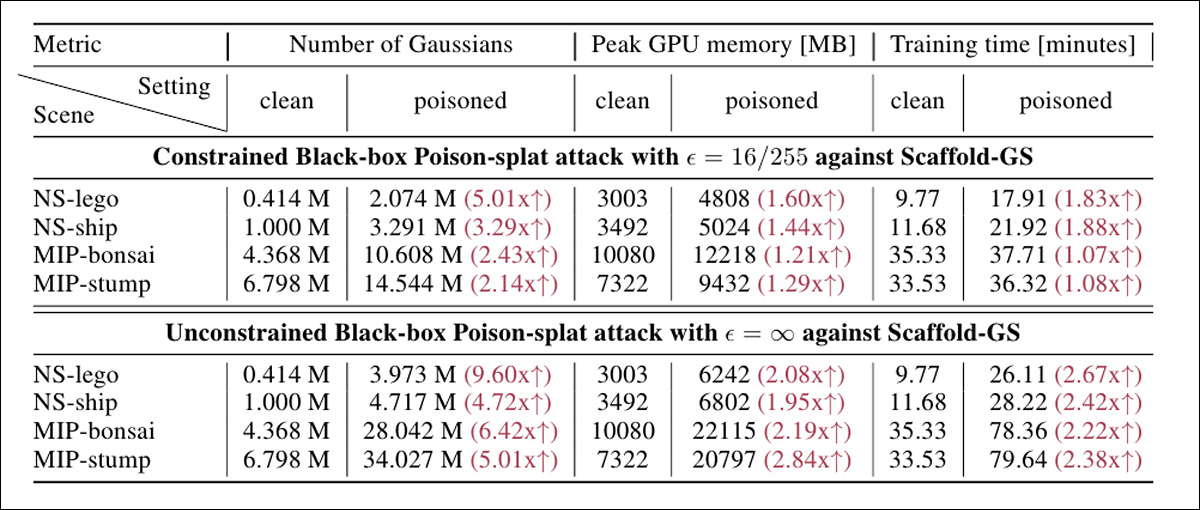

آزمایشات در برابر Scaffold-GS (مدل جعبه سیاه) در زیر نشان داده شده است. نویسندگان بیان می کنند که این نتایج نشان می دهد که poison-splat به خوبی به چنین معماری متفاوتی تعمیم می یابد (یعنی به اجرای مرجع).

نتایج آزمایش برای حملات جعبه سیاه به مجموعه داده های NeRF-Synthetic و MIP-NeRF360.

نویسندگان خاطرنشان می کنند که مطالعات بسیار کمی بر روی این نوع حملات هدف گیری منابع در فرآیندهای استنتاج متمرکز شده است. مقاله 2020 حملات تأخیر انرژی به شبکه های عصبی توانست نمونههای دادهای را شناسایی کند که باعث فعالسازی بیش از حد نورون میشود که منجر به مصرف ضعیف انرژی و تأخیر ضعیف میشود.

حملات زمان استنتاج در کارهای بعدی مانند حملات کاهش سرعت به استنتاج شبکه عصبی چند خروجی تطبیقی، به سمت تزریق درب پشتی بازدهو برای مدلهای زبان و مدلهای زبان بینایی (VLM)، در NICGSlowDown، و تصاویر پرمخاطب.

نتیجه گیری

حمله Poison-splat توسعه یافته توسط محققان از یک آسیبپذیری اساسی در Gaussian Splatting استفاده میکند – این واقعیت که پیچیدگی و چگالی گاوسیها را با توجه به موادی که برای آموزش داده میشود، اختصاص میدهد.

مقاله 2024 F-3DGS: مختصات و بازنمایی های فاکتوریزه شده برای سه بعدی پاشیدن گاوسی قبلاً مشاهده کرده است که تخصیص دلخواه گاوسی اسپلیت یک روش ناکارآمد است که اغلب موارد اضافی را نیز تولید می کند:

‘[This] ناکارآمدی از ناتوانی ذاتی 3DGS در استفاده از الگوهای ساختاری یا افزونگی ها ناشی می شود. ما مشاهده کردیم که 3DGS حتی برای نمایش ساختارهای هندسی ساده، مانند سطوح صاف، تعداد زیادی گاوسی غیرضروری تولید می کند.

«بهعلاوه، گاوسیانهای مجاور گاهی ویژگیهای مشابهی از خود نشان میدهند، که نشاندهنده پتانسیل افزایش کارایی با حذف نمایشهای اضافی است».

از آنجایی که تولید محدود گاوسی کیفیت بازتولید را در سناریوهای غیرحمله ای تضعیف می کند، تعداد فزاینده ای از ارائه دهندگان آنلاین که 3DGS را از داده های بارگذاری شده توسط کاربر ارائه می دهند، ممکن است نیاز به مطالعه ویژگی های تصاویر منبع داشته باشند تا امضاهایی را که نشان دهنده یک قصد مخرب هستند، مشخص کنند.

در هر صورت، نویسندگان کار جدید به این نتیجه میرسند که روشهای دفاعی پیچیدهتری برای سرویسهای آنلاین در مواجهه با نوع حملهای که آنها تدوین کردهاند، ضروری خواهد بود.

* تبدیل من از استنادهای درون خطی نویسندگان به لینک هایپرلینک

اولین بار در جمعه 11 اکتبر 2024 منتشر شد