تیمی از دانشمندان به تازگی چیزی را یافته اند که بسیاری از آنچه را که ما فکر می کردیم در مورد قابلیت های هوش مصنوعی می دانستیم تغییر می دهد. مدلهای شما فقط پردازش اطلاعات نیستند – آنها در حال توسعه تواناییهای پیچیدهای هستند که بسیار فراتر از آموزش آنهاست. و برای باز کردن این توانایی ها، باید نحوه صحبت کردن با آنها را تغییر دهیم.

مفهوم انقلاب فضایی

به یاد دارید زمانی که فکر می کردیم هوش مصنوعی فقط با الگوها مطابقت دارد؟ تحقیق جدید اکنون با ترسیم چیزی که آن را «فضای مفهومی» می نامند، جعبه سیاه یادگیری هوش مصنوعی را باز کرده است. یادگیری هوش مصنوعی را به عنوان یک نقشه چند بعدی تصور کنید که در آن هر مختصات مفهوم متفاوتی را نشان می دهد – چیزهایی مانند رنگ، شکل یا اندازه. محققان با تماشای نحوه حرکت مدلهای هوش مصنوعی در این فضا در طول آموزش، متوجه چیز غیرمنتظرهای شدند: سیستمهای هوش مصنوعی فقط به خاطر نمیسپارند – آنها درک پیچیدهای از مفاهیم را با سرعتهای مختلف ایجاد میکنند.

تیم تحقیقاتی خاطرنشان می کند: “با مشخص کردن پویایی یادگیری در این فضا، ما تشخیص می دهیم که چگونه سرعت یادگیری یک مفهوم توسط ویژگی های داده ها کنترل می شود.” به عبارت دیگر، برخی از مفاهیم، بسته به میزان برجسته بودن آنها در داده های آموزشی، سریعتر از دیگران کلیک می کنند.

این چیزی است که این موضوع را بسیار جالب میکند: وقتی مدلهای هوش مصنوعی این مفاهیم را یاد میگیرند، آنها را فقط بهعنوان اطلاعات مجزا ذخیره نمیکنند. آنها در واقع توانایی ترکیب و تطبیق آنها را به روشهایی که ما هرگز به صراحت به آنها آموزش ندادیم، توسعه می دهند. مثل این است که آنها در حال ساخت ابزار خلاقانه خود هستند – ما فقط دستورالعمل های درستی برای استفاده از آن به آنها نداده ایم.

به معنای این موضوع برای پروژه های هوش مصنوعی فکر کنید. مدلهایی که با آنها کار میکنید ممکن است ترکیب پیچیدهای از مفاهیمی را که هنوز کشف نکردهاید، درک کنند. مسئله این نیست که آیا آنها می توانند کارهای بیشتری انجام دهند یا خیر، بلکه این است که چگونه می توان آنها را وادار کرد تا به شما نشان دهند که واقعاً چه توانایی هایی دارند.

باز کردن قدرت های پنهان

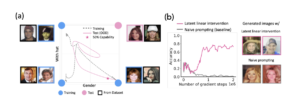

اینجاست که همه چیز جذاب می شود. محققان آزمایشی زیبا را طراحی کردند تا چیزی اساسی در مورد نحوه یادگیری مدلهای هوش مصنوعی نشان دهند. راه اندازی آنها به طرز فریبنده ای ساده بود: آنها یک مدل هوش مصنوعی را فقط بر روی سه نوع تصویر آموزش دادند:

- دایره های قرمز بزرگ

- دایره های آبی بزرگ

- دایره های قرمز کوچک

سپس تست کلید آمد: آیا مدل می تواند یک دایره آبی کوچک ایجاد کند؟ این فقط در مورد ترسیم یک شکل جدید نبود – بلکه در مورد این بود که آیا مدل واقعاً می تواند دو مفهوم مختلف (اندازه و رنگ) را به روشی که قبلاً هرگز ندیده بود درک کند و ترکیب کند.

آنچه آنها کشف کردند، نحوه تفکر ما را در مورد قابلیت های هوش مصنوعی تغییر می دهد. وقتی آنها از دستورهای معمولی برای درخواست یک “دایره آبی کوچک” استفاده کردند، مدل با مشکل مواجه شد. با این حال، این مدل در واقع می تواند دایره های آبی کوچک ایجاد کند – ما فقط راه درست را نپرسیدیم.

محققان دو تکنیک را کشف کردند که این را ثابت کرد:

- “مداخله نهفته” – این مانند یافتن درب پشتی در مغز مدل است. آنها به جای استفاده از اعلانهای معمولی، مستقیماً سیگنالهای داخلی را که نشاندهنده «آبی» و «کوچک» هستند، تنظیم کردند. تصور کنید که صفحههای مجزا برای رنگ و اندازه داشته باشید – آنها دریافتند که با چرخاندن این صفحهها به روشهای خاص، مدل میتواند ناگهان چیزی را تولید کند که لحظاتی قبل غیرممکن به نظر میرسید.

- “بیش از حد” – به جای درخواست ساده “آبی”، آنها با مقادیر رنگ بسیار خاص بودند. مثل تفاوت بین گفتن «آبی کن» با «آن را دقیقاً به این سایه آبی بساز: RGB(0.3، 0.3، 0.7).» این دقت بیشتر به مدل کمک کرد تا به توانایی هایی که در شرایط عادی پنهان شده بودند دسترسی پیدا کند.

هر دو تکنیک دقیقاً در یک نقطه از آموزش مدل شروع به کار کردند – حدود 6000 مرحله آموزشی. در همین حال، درخواستهای منظم یا به طور کامل شکست خوردند یا به بیش از 8000 مرحله برای کار نیاز داشتند. و این یک تصادف نبود – به طور مداوم در چندین آزمایش اتفاق افتاد.

این به ما چیزی عمیق میگوید: مدلهای هوش مصنوعی قابلیتها را در دو مرحله مجزا توسعه میدهند. اول، آنها در واقع یاد می گیرند که چگونه مفاهیم را در داخل ترکیب کنند – این چیزی است که در مرحله 6000 اتفاق می افتد. اما مرحله دومی وجود دارد که در آن آنها یاد میگیرند که چگونه این تواناییهای درونی را به روش عادی ما برای درخواست چیزها متصل کنند. مثل این است که مدل قبل از اینکه یاد بگیرد چگونه آن زبان را برای ما ترجمه کند به یک زبان جدید مسلط می شود.

پیامدها قابل توجه است. وقتی فکر می کنیم یک مدل نمی تواند کاری را انجام دهد، ممکن است اشتباه کنیم – ممکن است این توانایی را داشته باشد اما ارتباط بین اعلان های ما و قابلیت هایش را نداشته باشد. این فقط در مورد اشکال و رنگهای ساده صدق نمیکند – میتواند برای تواناییهای پیچیدهتر در سیستمهای هوش مصنوعی بزرگتر نیز صادق باشد.

هنگامی که محققان این ایده ها را بر روی داده های دنیای واقعی با استفاده از مجموعه داده چهره CelebA، آنها همان الگوها را پیدا کردند. آنها سعی کردند که این مدل تصاویری از “زنانی با کلاه” تولید کند – چیزی که در آموزش دیده نشده بود. درخواستهای منظم شکست خوردند، اما استفاده از مداخلات پنهان نشان داد که این مدل واقعاً میتواند این تصاویر را ایجاد کند. این قابلیت وجود داشت – فقط از طریق وسایل عادی قابل دسترسی نبود.

پارک و همکاران، دانشگاه هاروارد و تحقیقات NTT

غذای آماده کلیدی

ما باید در نحوه ارزیابی قابلیت های هوش مصنوعی تجدید نظر کنیم. فقط به این دلیل که یک مدل ممکن است قادر به انجام کاری با دستورات استاندارد نباشد به این معنی نیست که اصلا نمی تواند آن را انجام دهد. فاصله بین کارهایی که مدلهای هوش مصنوعی میتوانند انجام دهند و کاری که ما میتوانیم آنها را وادار به انجام آنها کنیم، ممکن است کمتر از آن چیزی باشد که فکر میکردیم – فقط باید در پرسیدن بهتر باشیم.

این کشف فقط تئوری نیست، بلکه اساساً نحوه تفکر ما در مورد سیستمهای هوش مصنوعی را تغییر میدهد. هنگامی که به نظر می رسد یک مدل با یک کار مشکل دارد، ممکن است لازم باشد بپرسیم که آیا واقعاً این قابلیت را ندارد یا اینکه به درستی به آن دسترسی نداریم. برای توسعه دهندگان، محققان و کاربران به طور یکسان، این به معنای خلاقیت در نحوه تعامل ما با هوش مصنوعی است – گاهی اوقات توانایی ما از قبل وجود دارد، فقط منتظر کلید مناسب برای باز کردن آن هستیم.