درک RAG قسمت اول: چرا لازم است

تصویر ویرایشگر | میان ترم و کانوا

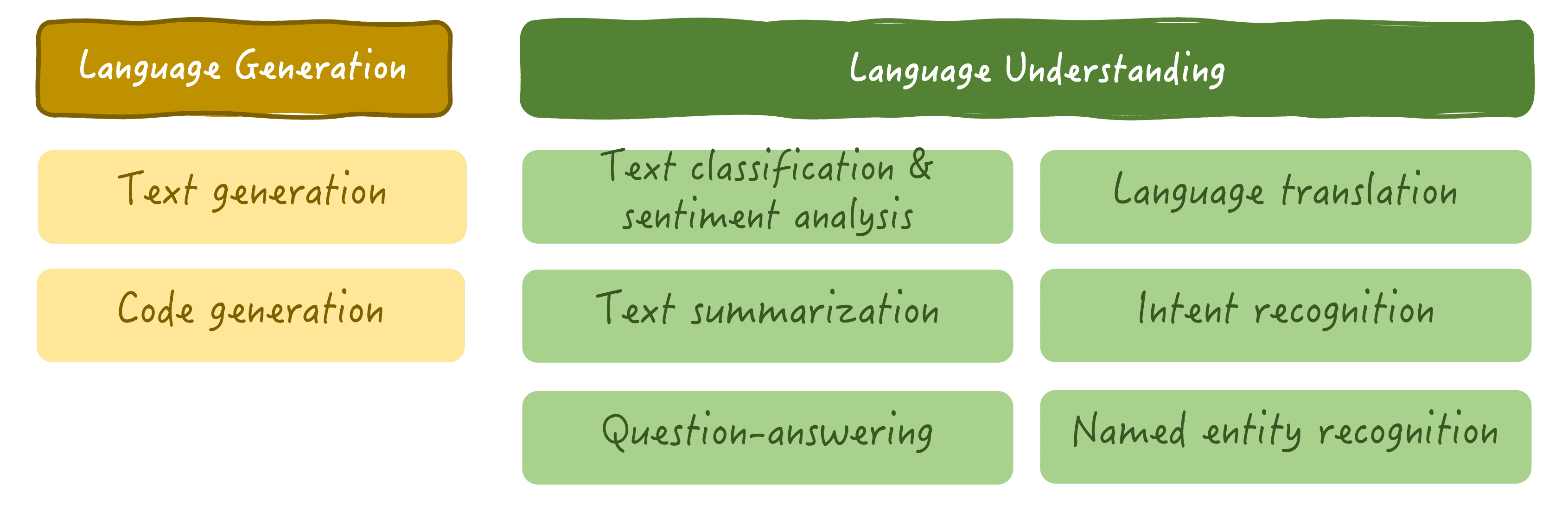

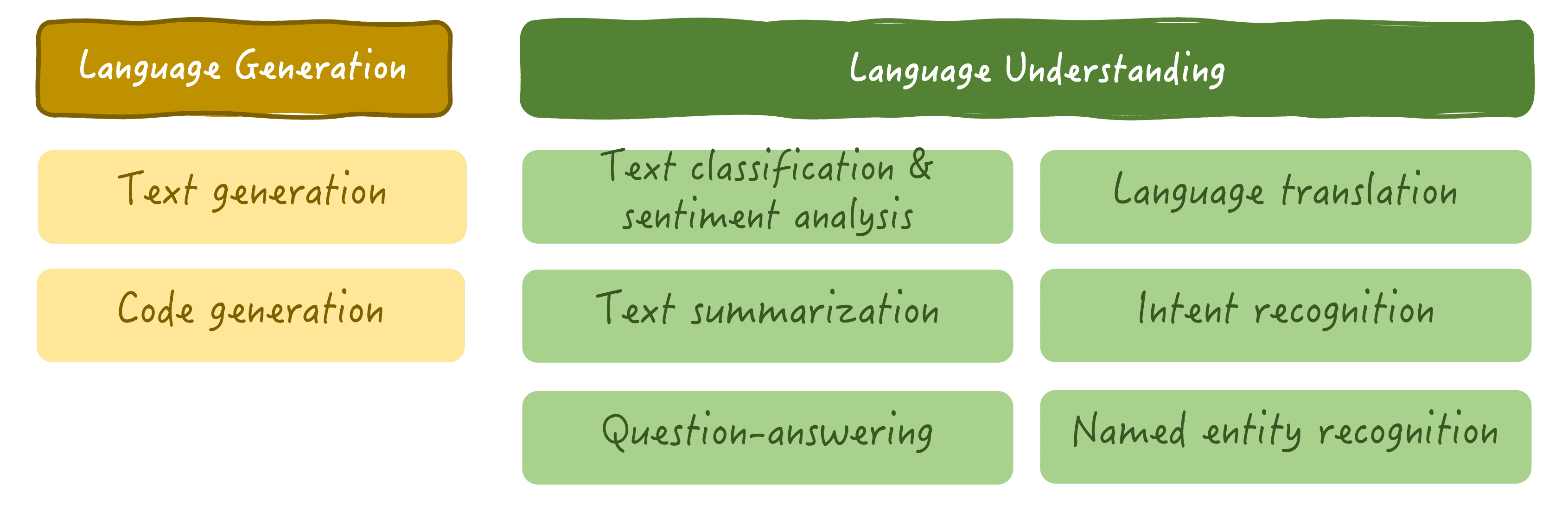

پردازش زبان طبیعی (NLP) رشته ای از هوش مصنوعی هدف (AI) آموزش کامپیوترها برای درک زبان نوشتاری و شفاهی انسان و تعامل با انسان با استفاده از چنین زبانی است. در حالی که روش های سنتی NLP برای دهه ها مورد مطالعه قرار گرفته اند، ظهور اخیر مدل های زبان اصلی (LLM) عملاً تمام تحولات در این زمینه را در اختیار گرفته است. LLM ها با ترکیب معماری های یادگیری عمیق پیچیده با مکانیزم توجه به خود که قادر به تجزیه و تحلیل الگوهای پیچیده و وابستگی های متقابل در زبان هستند، انقلابی در زمینه NLP و AI به طور کلی ایجاد کرده اند، زیرا طیف گسترده ای از وظایف تولید زبان و درک را می توانند انجام دهند. و طیف وسیعی از کاربردهای آنها: چت بات های مکالمه، تجزیه و تحلیل عمیق اسناد، ترجمه و غیره.

برخی از وظایفی که LLM ها اغلب انجام می دهند

قابلیت ها و محدودیت های LLM

بزرگترین LLM های همه منظوره که توسط شرکت های بزرگ هوش مصنوعی راه اندازی شده اند، مانند مدل های ChatGPT OpenAI، در درجه اول در نسل زبانیعنی از یک اعلان (پرس و جو، سوال یا درخواست فرموله شده توسط کاربر به زبان انسانی)، LLM باید با ایجاد کلمه در هر کلمه، پاسخی به زبان طبیعی به این اعلان تولید کند. برای امکان پذیر ساختن این کار به ظاهر دلهره آور، LLM ها بر روی مجموعه داده های بسیار بزرگ متشکل از میلیون ها یا حتی میلیاردها سند متنی آموزش می بینند که هر موضوعی را که می توانید تصور کنید پوشش می دهد. به این ترتیب، LLM ها به طور جامع تفاوت های ظریف زبان انسان را می آموزند، از شیوه ارتباط ما تقلید می کنند و با استفاده از دانش به دست آمده برای تولید “زبان انسان مانند” خود، سیال ارتباط انسان و ماشین را در سطوح بی سابقه ای قادر می سازند.

شکی نیست که LLM ها گام بزرگی به جلو در توسعه و افق های هوش مصنوعی بوده اند، اما از محدودیت های خود مستثنی نیستند. به طور مشخص، اگر یک کاربر از یک LLM برای یک پاسخ خاص در یک زمینه خاص (مثلاً آخرین اخبار) بخواهد، مدل ممکن است به تنهایی قادر به ارائه پاسخ مشخص و دقیق نباشد. دلیل: دانش LLM ها از جهان محدود به داده هایی است که آنها در معرض آنها قرار گرفته اند، به ویژه در مرحله آموزش. یک LLM معمولاً با آخرین اخبار بهروز نمیشود، مگر اینکه مرتباً دوباره آموزش ببینند (که ما دروغ نمیگوییم، فرآیندی بسیار پرهزینه است).

بدتر از آن، زمانی که LLM ها فاقد اطلاعات پایه برای ارائه یک پاسخ دقیق، مرتبط یا واقعی هستند، خطر قابل توجهی وجود دارد که همچنان پاسخ قانع کننده ای ایجاد کنند، حتی اگر این به معنای فرموله کردن آن بر اساس اطلاعات کاملاً ساخته شده باشد. این مشکل رایج در LLM ها به نام شناخته می شود توهمات: متن نادرست و بی اساس تولید می کند و در نتیجه کاربر را گمراه می کند.

چرا RAG پدیدار شد

حتی بزرگترین LLM های موجود در بازار نیز از این مشکل رنج برده اند منسوخ شدن داده ها، بازیافت پرهزینه و توهم تا حدودی مشکلاتی وجود دارد و غولهای فناوری به خوبی از خطرات و تأثیرات ناشی از استفاده از این مدلها توسط میلیونها کاربر در سراسر جهان آگاه هستند. به عنوان مثال، شیوع توهمات در مدلهای قبلی ChatGPT حدود 15 درصد تخمین زده شد که پیامدهای عمیقی بر شهرت سازمانهایی که از آنها استفاده میکنند دارد و قابلیت اطمینان و اعتماد به سیستمهای هوش مصنوعی را تضعیف میکند.

به همین دلیل است RAG (نسل تقویت شده بازیابی) وارد صحنه شد. RAG بدون شک یکی از پیشرفت های عمده در NLP پس از ظهور LLM ها بوده است، به دلیل رویکرد موثر آن در پرداختن به محدودیت های LLM فوق. ایده اصلی پشت RAG سنتز کردن است دقت و قابلیت جستجو از بازیابی اطلاعات تکنیکهایی که معمولاً توسط موتورهای جستجو استفاده میشوند، با درک عمیق زبان و قابلیتهای تولید LLM.

بهطور کلی، سیستمهای RAG LLMها را با گنجاندن اطلاعات متنی بهروز و واقعی در پرسشها یا درخواستهای کاربر بهبود میبخشند. این زمینه پس از یک مرحله بازیابی قبل از فرآیند درک زبان و تولید پاسخ بعدی توسط LLM به دست می آید.

در اینجا آمده است که چگونه RAG می تواند به حل مشکلات ذکر شده به طور سنتی در LLM ها کمک کند:

- منسوخ بودن داده ها: RAG می تواند با بازیابی و ادغام اطلاعات به روز از منابع خارجی به غلبه بر منسوخ شدن داده ها کمک کند تا پاسخ ها منعکس کننده آخرین دانش موجود باشند.

- هزینه های بازآموزی: با بازیابی پویا اطلاعات مربوطه، RAG نیاز به بازآموزی مکرر و پرهزینه را کاهش می دهد و به LLM ها اجازه می دهد بدون آموزش مجدد کامل بمانند.

- توهمات: RAG با استناد به پاسخها بر اساس اطلاعات واقعی برگرفته از اسناد واقعی، به کاهش توهمات کمک میکند و در نتیجه تولید پاسخهای نادرست یا ابداع شده فاقد هرگونه صحت را به حداقل میرساند.

در این مرحله، امیدواریم که اولین درک را از چیستی RAG و دلیل ایجاد آن برای بهبود راهحلهای موجود LLM به دست آورده باشید. مقاله بعدی در این مجموعه به درک رویکرد کلی در مورد نحوه عملکرد فرآیندهای RAG می پردازد.